Comment les scientifiques redéfinissent le succès

Classement des universités, facteur d'impact des revues, nombre de citations: certains affirment que ces méthodes de mesure de la «meilleure» science sont dépassées et constituent même un obstacle au progrès scientifique. La Suisse veut contribuer à la mise en œuvre d'alternatives - une tâche plus facile à dire qu'à faire.

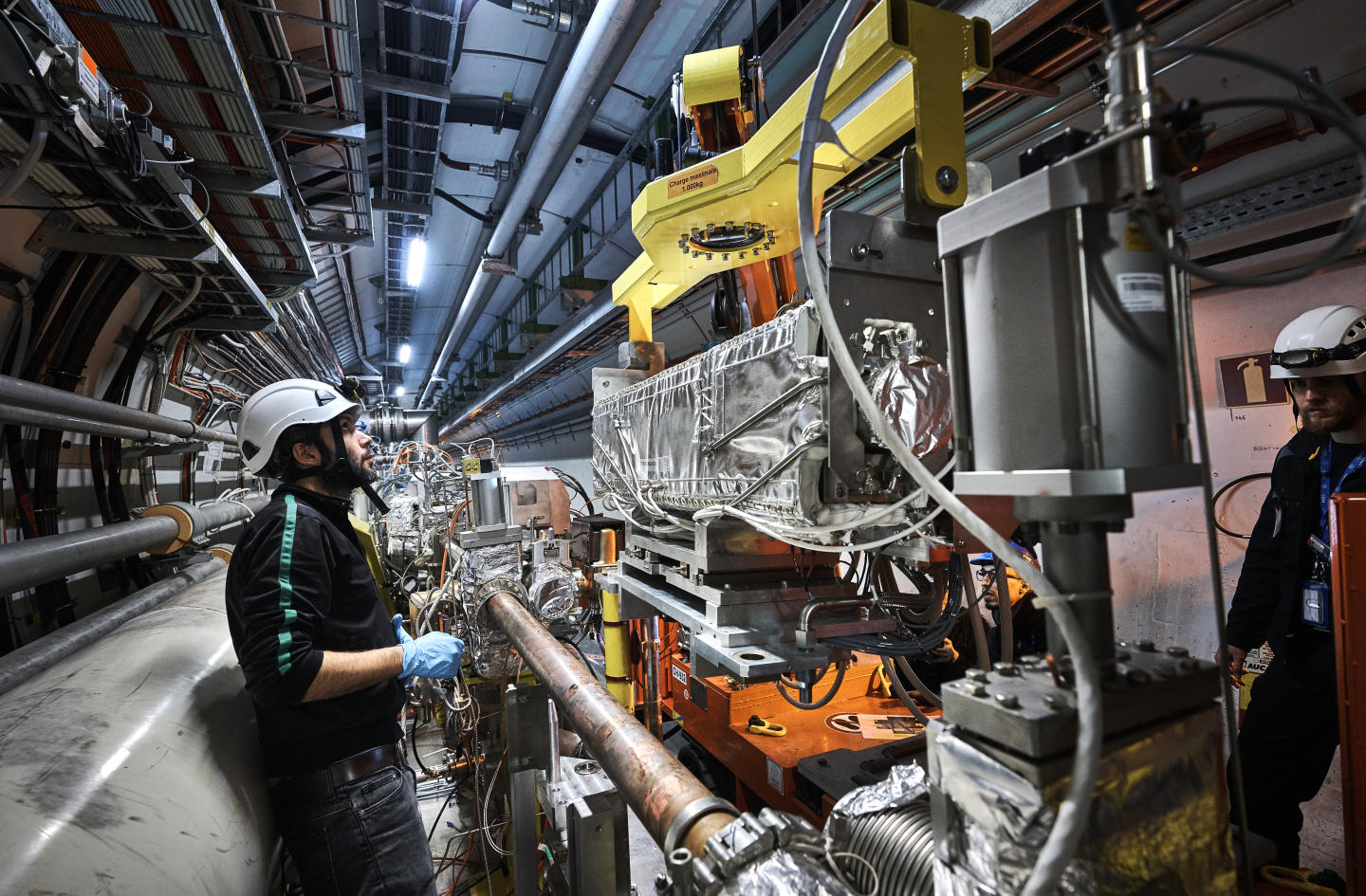

Selon un récent rapport du Conseil suisse de la scienceLien externe (CSS), les activités scientifiques – qu’il s’agisse de l’emploi de chercheurs, de la publication d’articles ou d’investissements publics et privés – ont considérablement augmenté au cours des dernières décennies. Cette croissance, à son tour, a donné lieu à des niveaux de concurrence sans précédent en matière de financement, de prix, de postes universitaires, d’annonces dans les principales revues et d’autres signes de réussite scientifique.

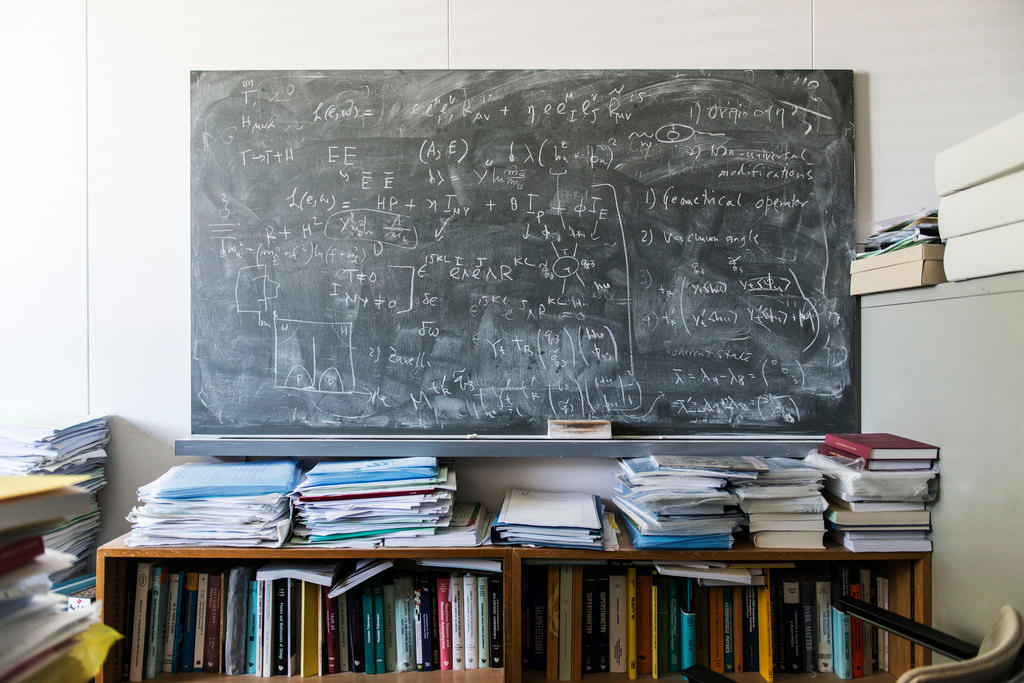

Avec la pression croissante du «publier ou succomber», de plus en plus d’importance est accordée aux mesures quantitatives de la réussite scientifique (voir encadré) – souvent axées sur le fait d’être cité dans des publications et le facteur d’impact de ces revuesLien externe – qui peuvent inciter les chercheurs à publier encore plus.

Les indicateurs scientifiques usuels

- Indice h: Cote numérique standardisée calculée à partir du nombre d’articles scientifiques qu’un chercheur a publiés et du nombre de fois que ces articles ont été cités. Bien que l’indice h vise à exprimer à la fois la productivité et l’impact d’un scientifique dans son domaine, les critiques disent qu’il est trop simpliste et qu’il ne permet pas de faire des comparaisons entre les différents domaines scientifiques.

- Facteur d’impact (FI): Utilisé pour classer les revues scientifiques selon leur importance dans leurs domaines respectifs. Un FI est calculé en fonction du nombre moyen de fois qu’un article publié dans une revue a été cité au cours des deux années précédentes. Le FI est une méthode de comparaison simple mais il a des défauts: il n’évalue pas directement la qualité de l’article, ne permet pas toujours de comparer différents domaines et peut être biaisé par quelques articles très cités.

- Les classements d’universités: Peut se fonder sur le transfert des connaissances et les citations ainsi que sur les performances pédagogiques. Alors que de plus en plus d’universités et d’instituts de recherche se disputent l’accès aux fonds, aux scientifiques et aux étudiants, les classements mondiaux sont devenus un outil de plus en plus utile pour évaluer la qualité et l’impact dans ces organisations. Mais certains soutiennent que les classements peuvent inciter les établissements à trop se concentrer sur la recherche à fort impact pour améliorer leur classement, et trop peu sur les responsabilités éducatives et sociales.

C’est un «paradoxe» de la science moderne, comme l’a mis en lumière Antonio Loprieno, président des Académies suisses des sciences, lors d’une récente conférence à Berne. «D’une part, l’utilisation de mesures contemporaines de la performance scientifique a augmenté de façon exponentielle avec l’augmentation du financement de la science, ce qui est pour nous une très bonne chose. D’autre part, nous émettons des réserves quant à leur équité, leur validité ou leur applicabilité», a-t-il dit.

Pour répondre à certaines de ces réserves, le Conseil suisse de la science a formulé cette année un certain nombre de recommandationsLien externe à l’intention de la communauté scientifique suisse visant à modifier la manière dont elle évalue et finance la recherche, notamment en utilisant des indicateurs qualitatifs pour soutenir (mais non remplacer) les indicateurs quantitatifs.

«Ces dernières années, les indicateurs [quantitatifs] ont été de plus en plus utilisés comme substitut à l’évaluation qualitative, une pratique qui a donné aux chercheurs de fausses incitations et menacé la qualité scientifique», indique le rapport. «Une stratégie nationale tenant compte de la diversité des exigences disciplinaires et institutionnelles pour une évaluation différenciée devrait être encouragée.»

Plus qu’un numéro

Selon les critiques, une trop grande importance accordée aux paramètres quantitatifs entraîne une détérioration de la rigueur scientifique que ces paramètres étaient censés soutenir en premier lieu – sans parler du stress énorme pour les scientifiques eux-mêmes.

«Selon Google, mon indice h est de 48, ce qui signifie que j’ai 48 articles qui ont au moins 48 citations. Je n’aime pas être réduit à un seul chiffre, mais il y a des gens sur cette planète qui pensent à moi comme à un chiffre», a déploré Stephen Curry, professeur de biologie structurelle à l’Imperial College de Londres, qui a également pris la parole à la conférence de Berne. «On peut utiliser des chiffres pour décrire certains aspects de la science, mais cette branche est une activité humaine avant tout. Il n’est pas possible de simplement mesurer la science, il faut inclure des jugements, des discussions et des avis d’expert».

Stephen Curry est à la tête du comité directeur de la Déclaration de San Francisco pour l’évaluation de la recherche (DORALien externe), l’une des récentes initiatives lancées pour redéfinir comment la science est évaluée et identifier de nouvelles directives. L’objectif est de jauger les chercheurs et les institutions d’une façon plus globale, tout en restant suffisamment efficace pour permettre à la science de continuer d’avancer.

Quantifier la qualité

Des critiques affirment également que les indicateurs quantitatifs, comme l’index h, sont sujets à distorsion et ne sont pas assez transparents au niveau de leur calcul et de leur utilisation. Ces critères décourageraient une recherche diversifiée, à haut risque et bon rendement au profit d’une recherche favorisant le conformisme et l’uniformité.

Pour Ellen Hazelkorn, directrice de l’Unité de recherche sur les politiques de l’enseignement supérieur à l’Institut de technologie à Dublin, ce genre d’indicateurs est particulièrement problématique à une époque où la science est à la portée de tout un chacun et pas uniquement destinée à quelques élites dans leur tour d’ivoire. Selon elle, les indicateurs tels que les classements d’institutions – par exemple le palmarès annuel des meilleures universités du monde établi par le journal Times Higher EducationLien externe – sont «totalement inadaptés à une forte implication de la société», car ils mettent l’accent sur la responsabilité uniquement dans la sphère académique et non dans l’entier de la communauté.

La simplicité est des facteurs qui peut expliquer l’attrait du monde scientifique pour les indicateurs basés sur les publications individuelles ou les citations, explique Stephen Curry. «Les indicateurs sont faciles à calculer, ils présentent une pseudo-objectivité séduisante et ils simplifient nos vies».

Pression et prestige

Mais quel est le prix à payer? Accorder trop d’attention à ces outils peut même ralentir le progrès scientifique, met en garde Stephen Curry. Les chercheurs ont alors tendance à envoyer leurs travaux aux journaux les plus prestigieux, augmentant ainsi les probabilités de rejet ou de rétractation qui risquent d’affecter la confiance du public dans la science.

De plus, concentrer l’attention des scientifiques sur les publications et le prestige signifie que d’autres activités importantes sont sous-évaluées et peuvent en pâtir – que ce soit l’enseignement, la communication ou l’encadrement des jeunes chercheurs.

La déclaration DORA a actuellement été signée par près de 14’000 individus et organisations. Le Manifeste de LeidenLien externe pour la mesure de la recherche a aussi suscité un grand intérêt de la part de la communauté académique. Les deux documents appellent à réduire la dépendance envers ces indicateurs quantitatifs, ou au moins à les utiliser en combinaison avec d’autres méthodes qualitatives qui se concentrent sur le contenu scientifique.

Quelles alternatives?

Pour Sarah de Rijcke, directrice adjointe au Centre d’études de science et technologie l’Université de Leiden aux Pays-Bas – là où est né le Manifeste de Leiden – une méthode d’évaluation alternative de la science serait l’approche «portefeuille», qui peut être adaptée à chaque situation, institution ou chercheur. «Les solutions universelles ne sont pas très efficaces», déclare-t-elle, étant donné que le type de recherches le plus valorisé par les indicateurs traditionnels varie en fonction des disciplines.

Pour un contexte d’évaluation particulier, Sarah de Rijcke recommande de s’appuyer sur des principes génériques pour créer un «récit standardisé» qui inclut l’expertise scientifique, les résultats – des publications, des subventions et même des médias sociaux – ainsi que les conséquences sur la science et la société.

Le comité de DORA compile également sur son site internet des exemples de telles approches, par exemple demander aux chercheurs de résumer leurs meilleures publications et contributions avec leurs propres mots sous forme de biosketchLien externe (sorte de curriculum vitae).

La responsabilité de la Suisse

Interrogé par swissinfo.ch, Antonio Loprieno a indiqué qu’en raison de ses moyens financiers élevés et de la souplesse de ses exigences administratives en comparaison avec les autres pays européens, la Suisse avait une obligation internationale d’initier ce changement. «Puisque nous possédons un système aussi bien financé, je pense que nous avons une certaine responsabilité envers le reste du monde. La Suisse doit expérimenter et tester des solutions de façon plus proactive, afin de déterminer comment surmonter les difficultés du système actuel.»

L’un des défis majeurs est, selon lui, de garantir que les jeunes scientifiques qui sont au début de leur carrière soient correctement soutenus durant cette transition vers des indicateurs scientifiques plus diversifiés. «Ma solution serait davantage de tolérance pour les projets sur le long terme. Nous avons maintenant tendance à soutenir et financer les recherches en fonction d’une vision à court terme, qui correspond à cette logique de compétition. Si nous étions prêts à débloquer des fonds sur une perspective de plus longue durée, cela pourrait enlever une certaine pression au commencement de la carrière et créer un système plus égalitaire».

(Traduction de l’anglais: Katy Romy et Marie Vuilleumier)

En conformité avec les normes du JTI

Plus: SWI swissinfo.ch certifiée par la Journalism Trust Initiative

Vous pouvez trouver un aperçu des conversations en cours avec nos journalistes ici. Rejoignez-nous !

Si vous souhaitez entamer une conversation sur un sujet abordé dans cet article ou si vous voulez signaler des erreurs factuelles, envoyez-nous un courriel à french@swissinfo.ch.