人工智能真像我们以为的那么智能吗?

计算机正越来越多地替我们做出重要决定。我们应该放手吗?瑞士Idiap研究院的团队向我们说明,为何机器智能基本上还只是一种假象。

閱讀本文繁體字版本請 點擊此處

机器会思考吗?这是英国数学家艾伦·图灵(Alan Turing)在其最著名论文(英)外部链接中提出的开放性问题。这篇1950年发表的论文为人工智能的构想与定义奠定了基础。为了回答自己的问题,图灵发明了“模仿游戏”(imitation game),如今仍被用于判断机器的智能。

这个游戏后来以“图灵测试”之名为人所知,游戏包括三个参加者:代号A的参加者是名男性,代号B的参加者为女性,而代号C的参加者扮演提问者,其性别不限。提问者不能看到另两位参加者,只能通过书面方式提出一系列问题,并根据得到的答案来判断谁是男性,谁是女性。男回答者的目的是用有误导性的答案欺骗提问者,而女回答者则必须便利对她正确身份的识别。

现在,设想计算机代替了参加者A。图灵写道,如果提问者无法分辨人和计算机,那么这台计算机应被认为具有智能,因为它被证明具有类似人类的认知能力。

70年后,测试的结果令人震惊。“目前,没有一个人工智能系统-确实一个也没有-能通过第一次图灵测试,”Idiap研究院院长埃尔韦·布尔拉(Hervé Bourlard)说道。该研究院专攻人工和认知智能。

相关内容

人工智能面临伦理考验

既不人工,也不智能

布尔拉声称早在20世纪70年代,“人工智能”一词就因被视作过时滑稽而不再使用,到90年代“出于广告、营销和商业原因”重新时髦起来。这位电子工程学教授补充说:“可是人工智能除了数学模型能力外,没有任何真正的进步。”

他对“人工智能”一词及其如今的使用方式仍持怀疑态度。他指出,就不存在“人工智能”这样东西,因为没有哪个系统反映出哪怕是一丁点的人类智能。即使是两三个月大的婴儿,也能做人工智能机器永远做不到的事。

一个简单的例子就足以说明这一点:拿起桌上的一杯水。连婴儿都明白,如果把杯子倒过来,杯里就没有水,成了空杯子。“这是为什么婴儿喜欢打翻杯子。世界上没有一台机器能明白这个区别,”布尔拉表示。

这个例子所展示的,也同样适用于常识。在布尔拉看来,机器永远也模仿不了人类特有的这种能力。

智能在于数据

然而,人工智能已在许多行业的企业里站稳脚跟,越来越多地效力于多种领域的决策过程,例如人力资源、保险、银行贷款,诸如此类。

通过分析互联网上的人类行为,机器正在了解我们都是谁、我们喜欢什么。然后推荐引擎过滤掉较不相干的信息,在社交媒体上向我们推荐可看的电影、可读的新闻,或者我们可能喜欢的衣服。

但这仍然不会使人工智能就真的智能了,布尔拉指出。1996年布尔拉就接手了Idiap的管理工作,他很喜欢谈论机器学习。他说,有三样东西让人工智能以自己的方式变得强大:计算能力、数学模型,以及庞大和无处不在的数据库。

愈发强大的计算机和信息的数字化,使得数学模型获得极大的改进。而拥有无限数据库的互联网,则完成了其余的工作,推动人工智能系统的能力步步深化。

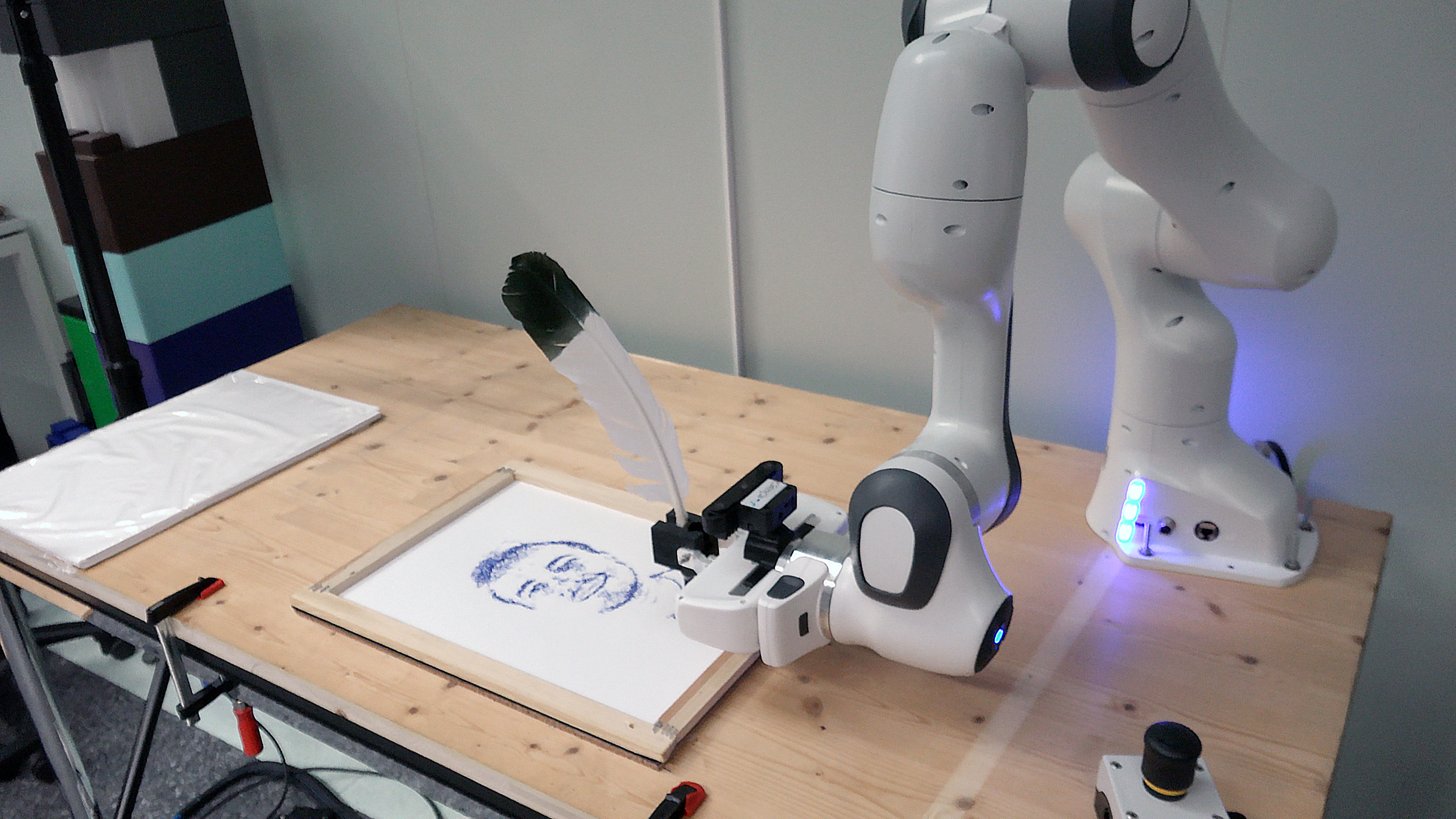

观看Idiap研究人员向公众展示人工智能的工作原理及能做的事:

相关内容

参观人工智能实验室

Idiap研究院尝试通过一些演示,向公众表明数据对人工智能系统而言有多么关键。这些演示将从4月1日起在洛桑的手博物馆(Musée de la main,法)外部链接展出。

举例来说,观众将有机会亲眼看到,我们智能手机摄像头背后基于人工智能的技术-取决于训练它的数据量大小-可以极大地提高低分辨率图像的质量,或者令其质量更差。

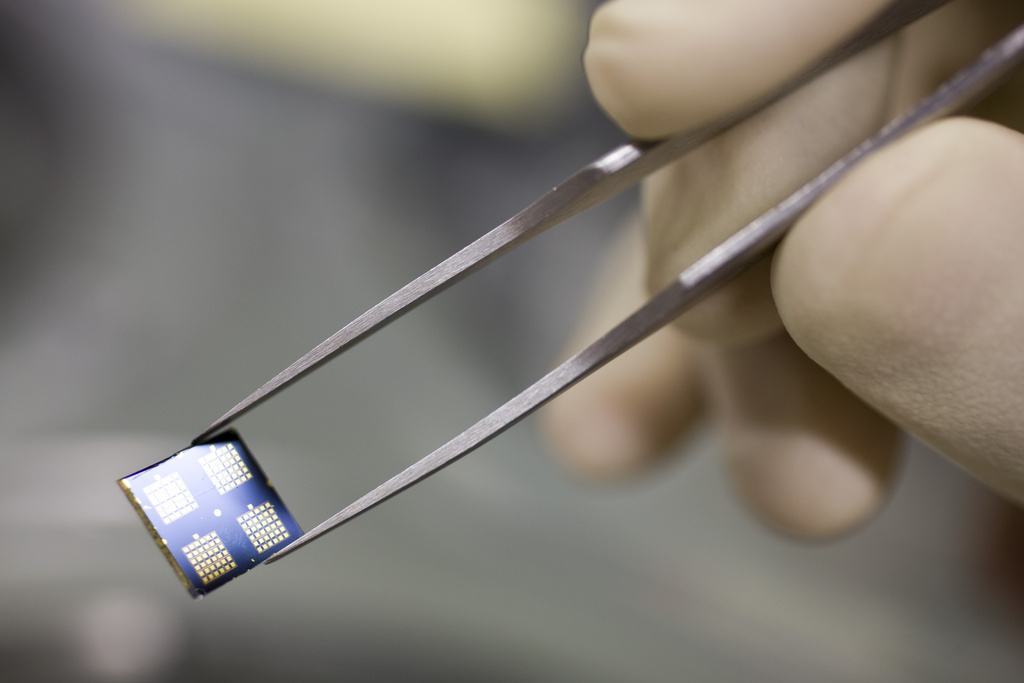

这个过程并不容易:需要许多必须由人(即使不是完全通过手工)加注(即“已添加标签”)的优质数据,才能让机器能够“理解”。

“我们不是在处理一个有生命的东西,而是个需要供给大量数据的系统,”领导Idiap计算生物成像研究团队的迈克尔·利布灵(Michael Liebling)解释道。

这并不是说人工智能就绝对安全。数据的有限性决定了机器的有限性。在利布灵看来,这应该使我们思考,真正的危险在哪里。

“危险真的在于这个世界被科幻机器接管吗?还是在于我们对数据的分配与加注?就我个人来说,我认为威胁在于数据的管理方式,而不在于机器本身,”他表示。

相关内容

“人工智能不会取代人类”

需要更加透明

被供给了海量数据的各种模型拥有多大的能力,Google和Facebook等科技巨头都非常清楚,也基于这种能力构筑了各自的业务。最让科学界担忧的,就是这一方面,以及某些人工任务的自动化。

前Google研究员Timnit Gebru批评了这个世界最常用搜索引擎使用的非常巨大与不可测知的语言学模型,她因此甚至被炒了鱿鱼。

机器学习模型的有限性,是这些模型并未-至少还没有-展示出可与我们的推断力相提并论的能力。它们能够提供答案,却解释不了为什么会得出这个结论。

领导Idiap推理与可解释性人工智能研究团队的安德烈·弗雷塔斯(André Freitas)说:“你还得使这些模型更为透明,让人类受众能够理解。”

弗雷塔斯的研究团队正在构建能够解释推理过程的人工智能模型。其目的是要把复杂的算法与科技术语变成能够理解、可为人所知的东西。随着人工智能开始渗透进我们的生活,他建议:“如果你遇到人工智能系统,叫它解释自己,以此来挑战它。”

相关内容

谷歌炒掉自己的伦理专家后会发生什么?

智能的假象

人工智能常被描绘成今日科技背后的驱动力。因而它会自然而然地引起人们的兴奋与很高的期望值。使用受人脑启发而建的神经网络模型的计算机,在此前无法想象的很多领域都大显身手。“这让我们以为人工智能会变得像我们一样聪明,解决我们的一切问题,”领导Idiap计算、认知与语言研究团队的罗内科·冯·德·普拉斯(Lonneke van der Plas)说道。

冯·德·普拉斯举了语言工具日益进步的各种能力,例如虚拟助理或自动翻译器。“这些都叫我们哑口无言,我们以为,如果连语言这么复杂的事计算机都能办到,那么它里面必定有智能,”她解释。

语言工具之所以能模仿我们,是因为里面包含的模型能够从海量文本中习得各种模式。但我们若是拿(声控)虚拟助理的能力与普通小孩的能力进行比较,比方说虚拟助理和小孩讨论纸飞机时,工具就需要更多数据来达到小孩的水平-而且它将难以学到常识等普通的知识。“要骗我们自己很容易,因为听起来像人,并不意味着后面就有人的智能,”冯·德·普拉斯指出。

无论如何,图灵70年前就说过:通过美化来人性化“思考机器”不值得尝试。一本书的价值不取决于它的封面。

相关内容

(译自英语:于雷)

符合JTI标准

您可以在这里找到读者与我们记者团队正在讨论交流的话题。

请加入我们!如果您想就本文涉及的话题展开新的讨论,或者想向我们反映您发现的事实错误,请发邮件给我们:chinese@swissinfo.ch。