“KI löst unsere Grundprobleme nicht”

Das Corona-Szenario erlaubt gewisse Rückschlüsse darauf, was eine Umwälzung der Gesellschaft durch die Nutzung von KI mit sich bringen könnte, schreibt Markus Christen.

Die Corona-Krise hatte innert weniger Wochen einen globalen ökonomischen Effekt zur Folge, von dem Dystopisten der Künstlichen Intelligenz (KI) regelmässig gewarnt hatten: einen enormen Einbruch der menschlichen Beschäftigung.

Natürlich waren es in diesem Fall nicht KI-gesteuerte Roboter und Software, welche menschliche Arbeitskraft ersetzt haben – vielen Menschen wurde schlicht verboten zu arbeiten, um die Verbreitung des Coronavirus zu bremsen. Und natürlich würde sich eine durch KI induzierte Veränderung der Arbeitswelt nie in einem derart horrenden Tempo vollziehen.

Aber in einem gewissen Sinn könnte das Corona-Szenario dennoch Rückschlüsse darauf erlauben, was eine Umwälzung der Gesellschaft durch eine umfassende Nutzung von KI mit sich bringen könnte: eine enorme Verschiebung der Einkommensstruktur mit sozialen Folgekosten, die massive Staatseingriffe zur Folge haben könnten. Doch ist eine derart markante Veränderung der Art, wie Menschen arbeiten und leben, aufgrund von KI wirklich zu erwarten?

Markus Christen ist Geschäftsführer der Digital Society InitiativeExterner Link (DSI) der Universität Zürich und Leiter des Digital Ethics Lab der DSI. Er forscht aktuell zu ethischen Fragen von Künstlicher Intelligenz und Cybersicherheit, zur Interaktion von autonomen Systemen und Menschen und zur Nutzung von Computerspielen in der Ethik-Bildung. Er ist einer der drei federführenden Forscher der TA-Swiss-StudieExterner Link zu Künstlicher Intelligenz.

Ein genauerer Blick auf die in den letzten Jahren enorm intensivierte Debatte rund um KI verweist auf ein komplexeres Bild, das aber drei grundlegende Beobachtungen erlaubt:

Erstens erweist sich KI als aktuelles Brennglas der an Informationstechnologie regelmässig herangetragenen Wünsche und Befürchtungen. Zweitens wird die Nutzung von KI uns nicht von den Grundproblemen befreien, die unser Zusammenleben immer schon geprägt haben. Drittens ist nicht die Entwicklung KI selbst, sondern ihr Zusammenspiel mit uns Menschen der Ankerpunkt für eine positive Nutzung dieser Basistechnologie.

Angst vor Kontrollverlust

Beginnen wir mit der ersten Beobachtung: Wie bei keiner anderen Technologie haben die Techniken der Informationsverarbeitung Utopien und Dystopien gleichermassen beflügelt. Grund dafür ist wohl, dass wir Menschen unsere Eigenart zunehmend an die Fähigkeit zum (bewussten) Umgang mit Information knüpfen. Und wenn Maschinen in diese Domäne eindringen, wirkt dies wie eine ultimative Kränkung und als unmittelbarste Form des Kontrollverlusts.

Doch die Angst, dass wir Menschen die Kontrolle verlieren und künftig nur noch Maschinen anstatt Menschen in wichtigen gesellschaftlichen Prozessen entscheiden, ist übertrieben. Denn Menschen bauen die KI-Systeme. Und setzen sie gemäss ihren Wünschen ein, weil sie bestimmte Aufgaben besser lösen kann als wir.

Selbst im autonomen Fall wird ein KI-System kein Selbstläufer werden, denn man wird regelmässig testen, ob das System noch das macht, was es soll. Daraus lässt sich übrigens eine wichtige Lehre ziehen: die Verhinderung eines dystopischen Einsatzes von KI muss nicht auf die Technik selbst schauen, sondern auf die Menschen, welche sie einsetzen wollen.

Mehr

Die Maschine und die Moral

Relevanter für den kritischen Blick auf KI dürften zudem die damit verbundenen Utopien sein: Der Trend zum datenbasierten Entscheiden ist bekanntlich sehr verbreitet. Dahinter verbirgt sich das Ideal des rationalen, objektiven und fairen Urteilens, im Gegensatz zu den zuweilen irrationalen und vorurteilsbehafteten Entscheiden, zu denen wir Menschen neigen.

Ob allerdings rein rationale Entscheide einer KI, die auf enorme Datenmengen zurückgreifen kann – wir lassen einmal alle komplexen Fragen über Qualität und Bias dieser Daten beiseite – auch menschengerecht sind, ist fraglich.

Wenn zum Beispiel künftig nur noch eine KI nach rationalen Kriterien über eine Kreditvergabe bestimmen sollte, verarmt damit auch die Entscheidungsvielfalt. Das könnte ein Problem sein. Menschen treffen zwar immer wieder falsche Entscheide, aber für das Gesamtsystem muss das nicht unbedingt schlecht sein.

Unterschiedliche Interpretationen von Gerechtigkeit

Dieses Fazit führt auf eine zweite Beobachtung: KI mag objektivierend erscheinen, löst aber Grundfragen nicht, die mit vielen menschlichen Entscheidungsproblemen zu tun haben. Das lässt sich an einem bekannten Beispiel illustrieren: 2016 machte der Compas-Algorithmus der US-Firma Northpointe Schlagzeilen.

Das KI-System liefert US-Richterinnen und -Richtern, die über die frühzeitige Haftentlassung von Straftätern befinden müssen, Einschätzungen zur Rückfallgefahr. Eine Organisation für investigativen Journalismus namens “ProPublica” untersuchte die Arbeitsweise des Systems und kam zum Schluss, es mache rassistische Prognosen.

Tatsächlich attestierte Compas Afroamerikanern eine fast doppelt so hohe Rückfallquote wie Weissen – und dies, obwohl die Hautfarbe als Kriterium im Programm explizit ausgeschlossen war. Doch die ursprüngliche Vermutung von “ProPublica”, wonach die Entwickler beim Schreiben des Algorithmus zu wenig sorgfältig oder sogar implizit rassistisch waren, erwies sich als falsch.

Forscherinnen und Forscher konnten zeigen, dass sich hinter dem Prognose-System ein Grundproblem verbirgt: Fairness lässt sich unterschiedlich interpretieren – bereits der antike Philosoph Aristoteles hielt fest, dass es unterschiedliche Arten von Gerechtigkeit gibt.

Giesst man diese Fairness-Interpretationen – für die es gleichermassen gute Gründe gibt – in Algorithmen, können sich diese gegenseitig ausschliessen: Das Ausmerzen einer Form von Unfairness hat automatisch andere Formen von Unfairness zur Folge.

Wir können also der Frage, welche Art von Fairness im jeweiligen Fall relevant ist, nicht aus dem Weg gehen. Daraus folgt eine weitere wichtige Lehre: KI kann eine Schein-Objektivität erzeugen, die uns nicht von der Verantwortung entbindet, uns diesen Grundfragen zu stellen.

Zusammenspiel von Mensch und Maschine

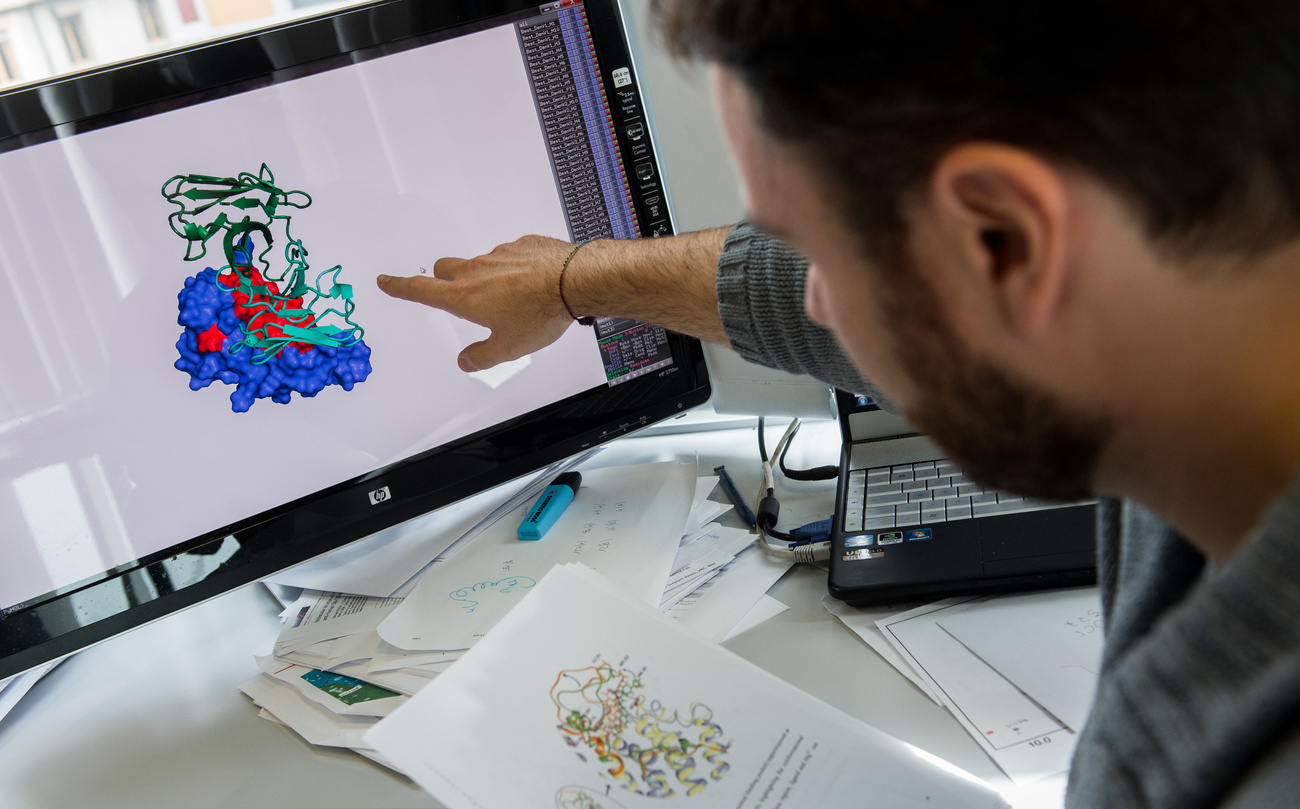

Damit ist aber nicht gesagt, dass KI sowohl bezüglich Ängsten und Wünschen eine überbewertete Technologie ist. Denn gerade die neuen Formen von KI wie “deep learning” erlauben uns Menschen neue Zugänge zu schwierigen Problemen: KI hat das Potenzial, uns klüger zu machen, weil sie ganz anders funktioniert als wir und riesige Datenmengen verarbeiten kann, die wir selbst nie überblicken können.

Solche Systeme können uns vielleicht auf eigene Vorurteile und systematische Fehler aufmerksam machen; sie gibt uns die Möglichkeit, uns in ihr zu spiegeln. KI nimmt uns keine Entscheidungen ab, kann aber als eine Art Zweitmeinung Empfehlungen machen.

Das ist positiv, gerade wenn es um schwierige Entscheidungen geht. Zentral dabei bleibt aber: Es muss immer ein Zusammenspiel von Mensch und Maschine sein. Dieses Zusammenspiel zu verstehen und zu optimieren sollte das Ziel künftiger Forschungsanstrengungen sein.

Der Artikel gibt die Meinung des Autors wieder, die sich nicht unbedingt mit der Meinung der Redaktion von swissinfo.ch decken muss.

Dieser Artikel wurde am 15. April 2020 auf Higgs.ch veröffentlichtExterner Link, dem ersten unabhängigen Magazin für Wissen in der Schweiz. SWI swissinfo.ch veröffentlicht Beiträge von Higgs in loser Folge.

In Übereinstimmung mit den JTI-Standards

Einen Überblick über die laufenden Debatten mit unseren Journalisten finden Sie hier. Machen Sie mit!

Wenn Sie eine Debatte über ein in diesem Artikel angesprochenes Thema beginnen oder sachliche Fehler melden möchten, senden Sie uns bitte eine E-Mail an german@swissinfo.ch