Les IA échappent au contrôle démocratique

Nous avons désespérément besoin de plus d’attention, de personnel et de fonds pour mettre en place des systèmes de gouvernance de l’intelligence artificielle (IA) semblables à ceux introduits dans les secteurs aérien, pharmaceutique et alimentaire, déclare le scientifique et communicateur scientifique Lê Nguyên Hoang.

Le 29 mars, une lettre ouverteLien externe demandant de «mettre en pause les expériences géantes en matière d’intelligence artificielle (IA)» a été publiée et signée à ce jour par plus de 20’000 universitaires et chefs de file du secteur technologique. Cet appel n’a que trop tardé.

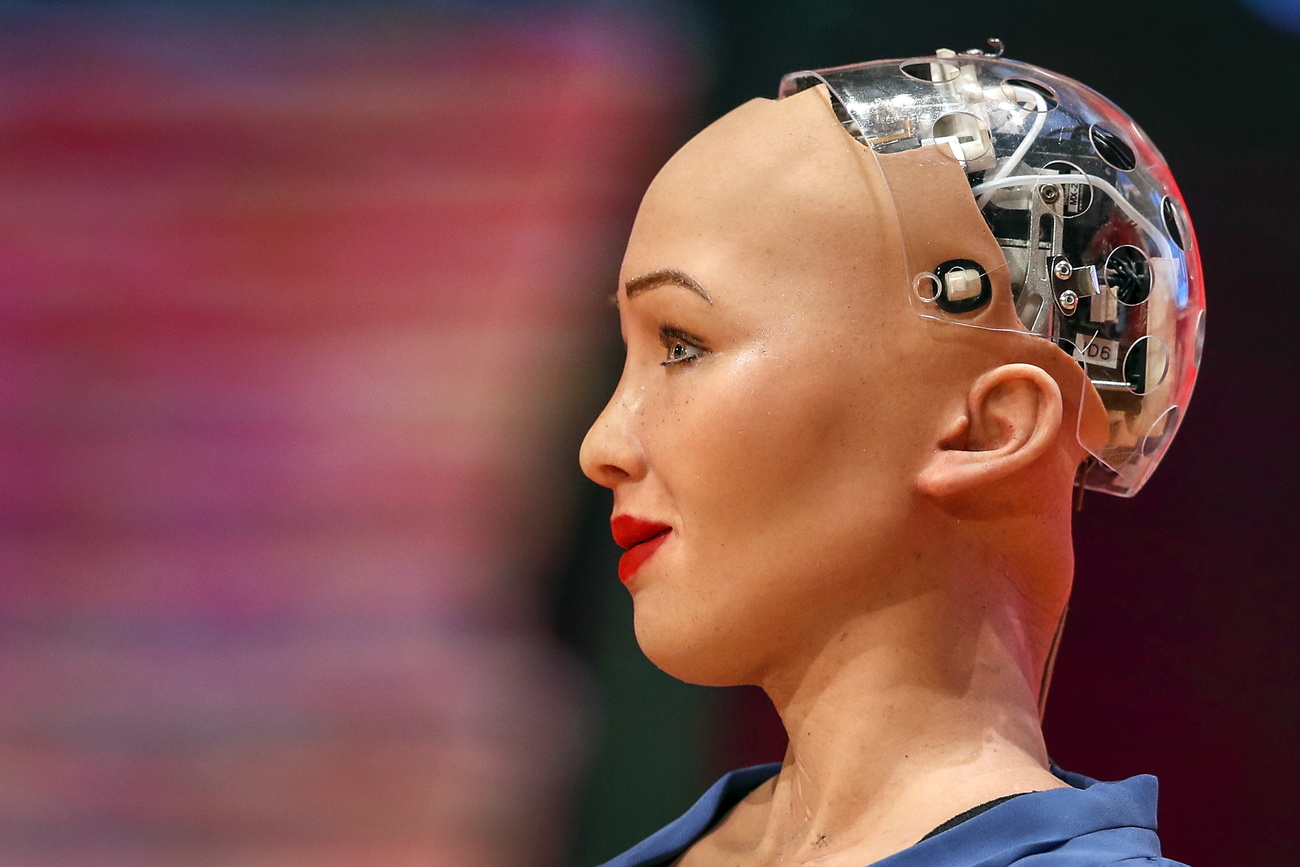

Au cours de la dernière décennie, des algorithmes impressionnants ont été développés à la hâte et déployés à grande échelle, comme ChatGPT et Midjourney. Des IA similaires ont été largement commercialisées, pour la détection des fraudes, le filtrage des CV, la vidéosurveillance et le service à la clientèle. Mais leur principale application est sans doute le marketing.

Plusieurs des géants technologiques actuels, tels que Google, TikTok et Meta, tirent principalement profit du ciblage publicitaire, tandis que le premier client public de ChatGPT n’était autre que Coca-Cola. Cela devrait déjà être un signal d’alarme.

Lê Nguyên Hoang est cofondateur et PDG de la start-up Calicarpa, spécialisée dans la cybersécurité, ainsi que cofondateur et président de l’association à but non lucratif Tournesol. La chaîne YouTube de Hoang, «Science4AllLien externe», a dépassé les 18 millions de vues depuis son lancement en 2016.

En outre, il a été démontré que les algorithmes diffusent des informations erronées, recommandent de pseudo-médicaments, mettent en danger la santé mentale et ont été utilisés pour coordonner des marchés illégaux (voire de l’esclavage). Ils ont également alimenté la haine, aidé à déstabiliser des démocraties et même contribué à des génocides, comme l’affirment les Nations unies et Amnesty International. Les algorithmes menacent la sécurité nationale.

Pourtant, leur développement est extrêmement opaque. Pratiquement aucune entité extérieure ne peut jeter un coup d’œil aux algorithmes de Google, Meta ou OpenAI. Les forces d’opposition internes ont même été supprimées: Google a licencié son équipe d’éthique, Meta a démantelé son équipe d’innovation et Microsoft a licencié une équipe d’éthique après avoir tiré la sonnette d’alarme sur le déploiement précipité, non éthique et non sécurisé. De puissantes entreprises à la recherche de profits ont réussi à créer un état mondial dans lequel leurs algorithmes peuvent être conçus sans avoir à rendre de comptes.

Plus

ChatGPT: intelligence, stupidité ou malveillance artificielles?

Il est urgent de mettre en place une gouvernance efficace de l’IA

L’industrie du logiciel est loin d’être la première industrie hors contrôle. Pendant des décennies, les compagnies aériennes, l’industrie automobile, l’industrie pharmaceutique, l’industrie alimentaire, le tabac, la construction et l’énergie, entre autres, ont commercialisé des produits non contrôlés. Cela a coûté des millions de vies. Les sociétés civiles ont fini par s’opposer à l’absence alarmante de responsabilité. Dans toutes les démocraties, des lois strictes et des agences de régulation puissantes et bien financées assurent désormais le contrôle démocratique de ces marchés. L’industrie du logiciel a besoin d’une surveillance similaire.

Il est urgent de favoriser les technologies sûres et éthiques, plutôt que d’exiger de nos pays qu’ils prennent la tête de la course aux IA accrocheuses. Concrètement, le caractère impressionnant des algorithmes qui gèrent nos réseaux intelligents, nos voitures, nos avions, nos centrales électriques, nos banques, nos centres de données, nos réseaux sociaux et nos smartphones devrait avoir beaucoup moins d’importance que leur cybersécurité. Comme mon collègue et moi-même l’avons souligné dans un livre publié en 2019, si ces algorithmes sont fragiles, vulnérables, détournés ou confiés à un fournisseur peu fiable, ou s’ils violent les droits de l’homme – ce qui est généralement le cas -, nous serons tous en grand danger.

Pourtant, l’industrie du logiciel et le monde universitaire, ainsi que les incitations juridiques et économiques actuelles, entravent en grande partie l’état d’esprit en matière de sécurité. Trop souvent, les chercheurs les plus cités, les plus célèbres et les plus financés, les postes les mieux rémunérés dans le secteur des logiciels et les entreprises les plus prospères sont ceux qui négligent la cybersécurité et l’éthique. Un nombre croissant d’experts estiment que cela doit changer. Il y a urgence.

Peu de temps pour agir

Nos démocraties ne peuvent probablement pas se permettre les décennies qui ont été nécessaires pour mettre en place des lois et des agences d’inspection dans d’autres secteurs. Compte tenu du rythme auquel des algorithmes plus sophistiqués sont développés et déployés, nous ne disposons que d’un très court laps de temps pour agir. La lettre ouverte que j’ai signée avec d’autres chercheurs en IA vise à prolonger légèrement cette fenêtre.

L’installation d’un contrôle démocratique sur les algorithmes les plus critiques d’aujourd’hui est une entreprise urgente, énorme et fabuleuse, qui ne sera pas réalisée en temps voulu sans la participation d’un grand nombre d’individus aux talents, à l’expertise et aux responsabilités divers.

Le premier défi à relever est celui de l’attention. Nous devons tous investir d’urgence beaucoup plus de temps, d’énergie et de fonds pour nous assurer que nos collègues, nos organisations et nos institutions accordent beaucoup plus d’attention à la cybersécurité. Les employés des grandes entreprises technologiques ne doivent plus être invités et célébrés, en particulier dans les universités et les médias, sans que la sécurité et l’éthique des produits qui les financent ne soient remises en question. Plus généralement, dans toutes les discussions sur la technologie, il faut se demander «ce qui peut mal tourner».

Le deuxième défi est d’ordre institutionnel. Si de nouvelles lois sont nécessaires, les algorithmes à grande échelle sont probablement déjà en train de violer les lois existantes, par exemple en profitant d’escroqueries basées sur la publicité. Toutefois, l’absence totale de contrôle externe empêche la justice d’être rendue. Nous devons exiger des décideurs politiques qu’ils mettent en place des agences de régulation bien financées pour faire respecter la loi en ligne.

La Suisse a souvent joué un rôle exemplaire dans l’établissement de normes démocratiques. C’est l’occasion de poursuivre cette noble tradition. En outre, l’arc lémanique a récemment cherché à devenir une «Trust Valley» dans le domaine de la confiance numérique et de la cybersécurité. L’autonomisation des organisations d’inspection et de cybersécurité sera sans doute essentielle pour être considéré comme tel dans le monde entier.

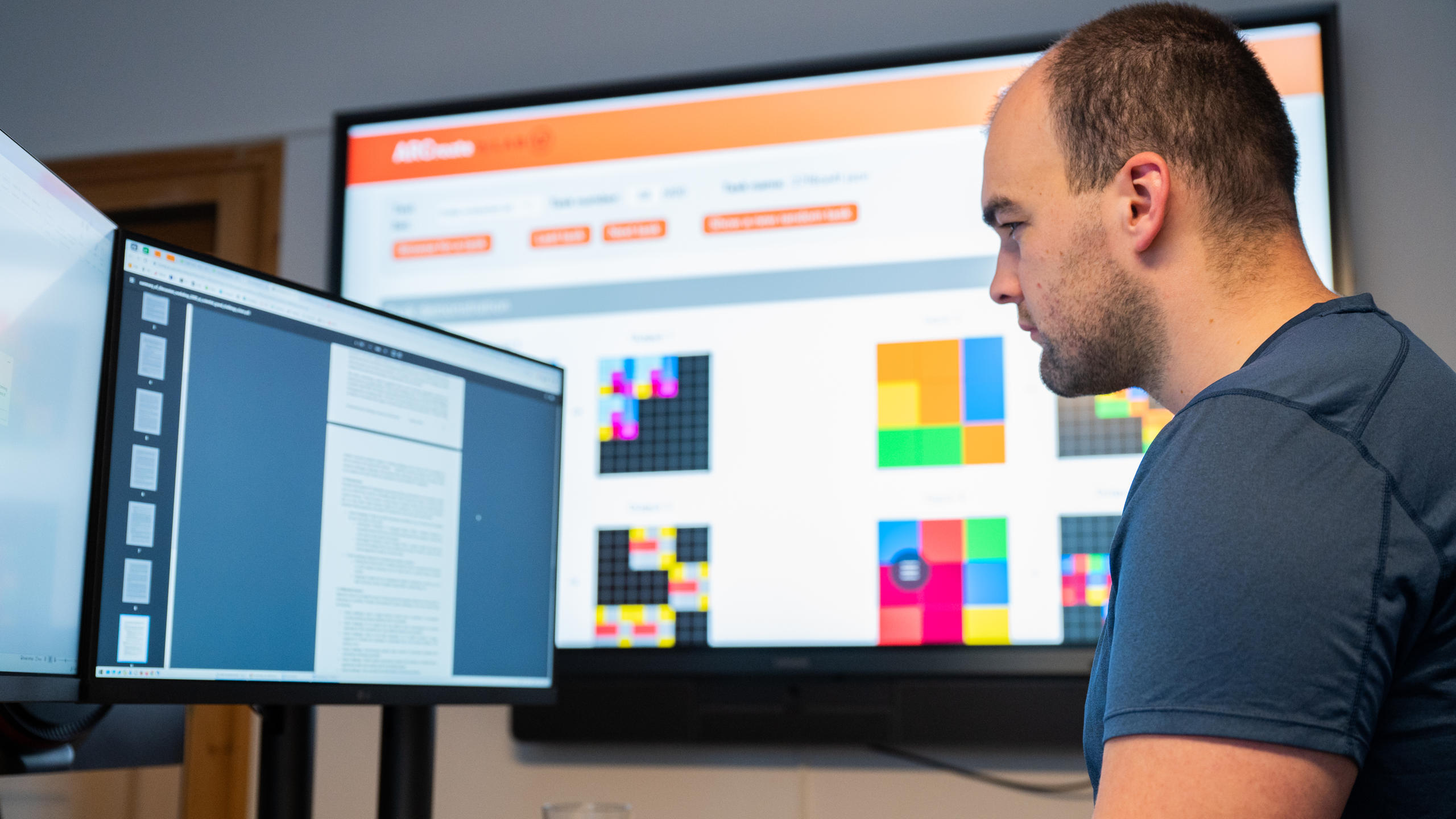

Un troisième défi consiste à concevoir des alternatives sécurisées, gouvernées démocratiquement, aux algorithmes les plus percutants d’aujourd’hui. C’est ce à quoi j’ai consacré la majeure partie des cinq dernières années, lorsque mes collègues et moi-même avons mis sur pied le projet à but non lucratif Tournesol. Essentiellement, l’algorithme de Tournesol résulte d’un vote sécurisé et équitable sur son comportement préféré par la communauté des contributeurs de Tournesol, que tout le monde est invité à rejoindre.

Plus vite nous donnerons la priorité à la sécurité de nos écosystèmes d’information, plus vite nous aurons une chance de protéger nos sociétés des vulnérabilités massives actuelles en matière de cybersécurité.

Relu et vérifié par Sabina Weiss, traduit de l’anglais par Kessava Packiry

Les opinions exprimées dans cet article sont uniquement celles de l’auteur et ne reflètent pas nécessairement la position de SWI swissinfo.ch.

Plus

Les gouvernements et les entreprises n’arrêteront pas la course à l’IA

En conformité avec les normes du JTI

Plus: SWI swissinfo.ch certifiée par la Journalism Trust Initiative

Vous pouvez trouver un aperçu des conversations en cours avec nos journalistes ici. Rejoignez-nous !

Si vous souhaitez entamer une conversation sur un sujet abordé dans cet article ou si vous voulez signaler des erreurs factuelles, envoyez-nous un courriel à french@swissinfo.ch.