La Suisse aspire à une IA aux capacités cognitives «humaines»

Les développeurs suisses du numérique sont jetés dans la course mondiale à la création d’une intelligence artificielle à même de «penser» comme l’humain. Certains de ces acteurs affirment être proches du Graal. Faut-il prendre cela pour argent comptant?

Depuis le lancement public de ChatGPT en 2022, des millions de gens dans le monde ont pris le pli d’interagir avec une IA comme si elle était une personne. Mais jusqu’ici, aucun outil d’intelligence artificielle ne s’est montré intelligent au sens humain du terme.

Les plateformes d’IA accessibles les plus répandues sont les grands modèles de langage (Large Language Model ou LLM) fonctionnant au moyen de prédictions basées sur des motifs récurrents appris à partir de quantités massives de données. La plupart sont incapables d’apprendre en temps réel et d’apprivoiser de nouvelles informations, au contraire du cerveau humain. «Elles nous donnent l’illusion d’être aussi intelligentes que nous, mais il ne s’agit que d’une imitation statistique, pas d’une véritable compréhension», explique Torsten Hoefler, professeur au département d’informatique de l’École polytechnique fédérale de Zurich (EPFZ).

Pour combler le fossé entre l’humain et la machine, entreprises et instituts de recherche partout sur la planète se livrent à une course frénétique pour développer une intelligence artificielle générale (IAG), capable de comprendre la complexité du monde, d’apprendre de manière autonome et de s’adapter aux situations. Tout comme l’humain. L’IAG est l’objectif de nombreux acteurs du domaine, car elle permettrait aux machines d’effectuer virtuellement n’importe quelle tâche avec la précision et l’agilité d’homo sapiens.

En Suisse, certains développeurs pensent être proches de l’intelligence humaine. Mais une partie des experts se demandent si les LLM et autres modèles de même acabit sont à même d’atteindre un jour cet objectif. Ils se posent plus largement la question de savoir si une IA «humaine» est un objectif souhaitable.

Tester l’intelligence artificielle

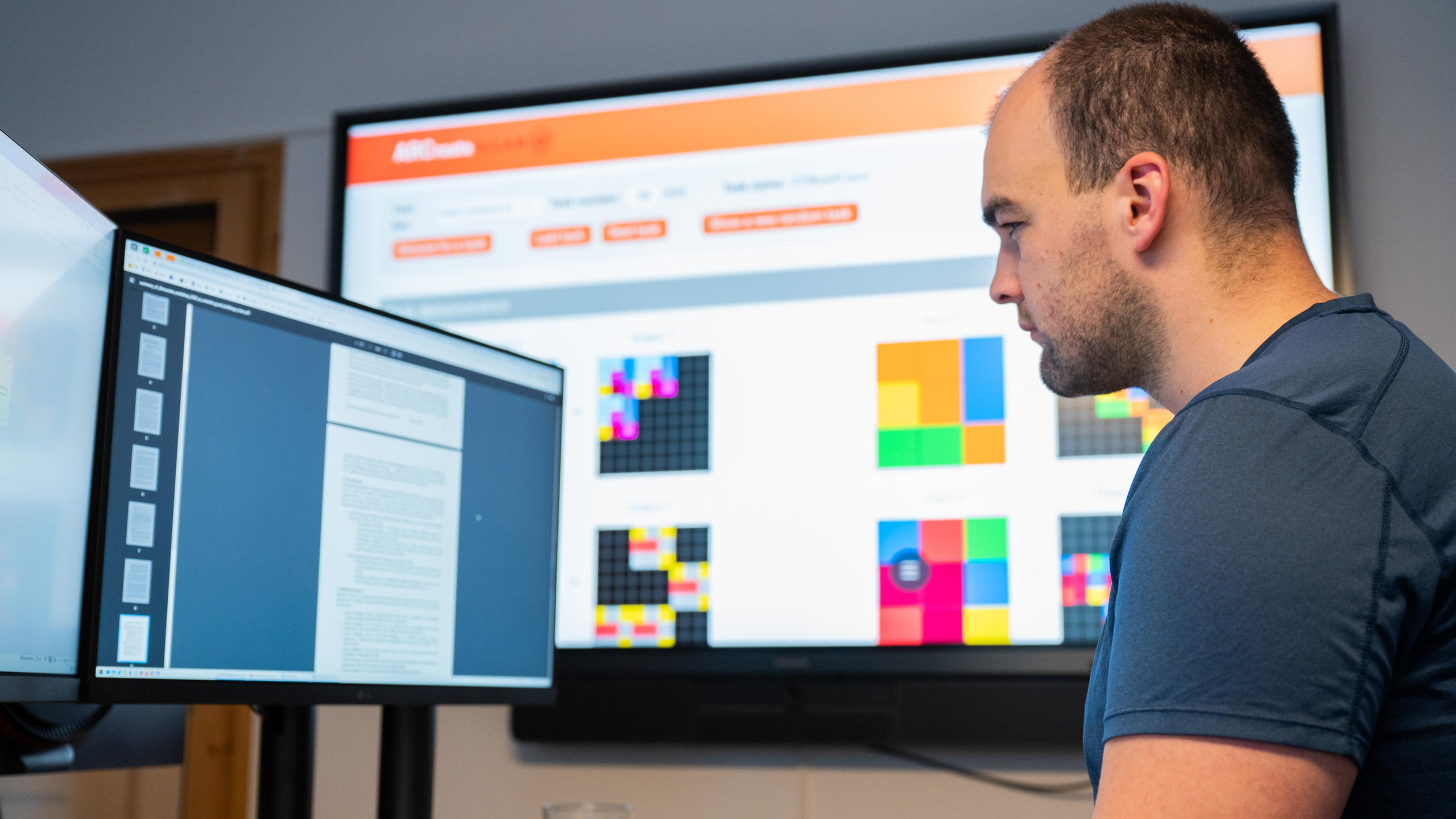

Dans cette course, la start-up suisse Giotto.ai se bat dans le peloton de tête. Et même au premier rang dans le cadre du concours ARC-AGI, une compétition mondiale qui mesure au moyen de casse-têtes visuels la proximité des systèmes d’IA avec le raisonnement humain.

L’ARC-AGI (Abstraction and Reasoning CorpusLien externe) est un des principaux référentiels mondiaux dans la mesure des progrès vers l’intelligence artificielle générale. Il se présente sous la forme d’énigmes visuelles qui testent la capacité des IA à raisonner de manière abstraite et à généraliser à partir d’exemples. Autant de tâches d’ordinaire assez aisées pour l’humain, mais qui restent difficiles pour les systèmes d’IA actuels.

Au moment de rédiger ces lignes, Giotto.ai indique avoir résolu 27,08% des énigmes. Mieux que les fameux modèles de langage Grok 4 ou GPT-5. La phase actuelle du concours s’achève le 3 novembre.

À Davos, l’institut de recherche Lab42 est lui aussi en quête de l’intelligence artificielle générale en soutenant des programmeurs du monde entier qui tentent de résoudre les tests ARC avec leurs outils propres. En 2024, l’institut annonçaitLien externe avoir établi un nouveau record mondial, une de ses équipes ayant résolu 34% des tests ARC dans le cadre d’un défi inofficiel.

Plus

Un pôle de recherche en intelligence artificielle «neutre» voit le jour à Davos

Si ces performances sont impressionnantes, elles restent très en deçà de celles de l’intelligence humaine. Créateur du test ARC-AGI, François Chollet estimeLien externe qu’un être humain «intelligent» serait capable de résoudre plus de 95% des énigmes sans entraînement préalable.

Giotto.ai et Lab42 estiment que gagner le concours démontrerait qu’ils sont sur le point de créer une technologie qui fonctionne comme le cerveau humain. Une technologie créative, capable d’apprendre en temps réel et rapide dans l’acquisition de nouvelles compétences.

Les LLM insuffisamment intelligents

Directeur scientifique de l’Institut Dalle Molle pour l’intelligence artificielle (IDSIA), Marco Zaffalon juge pour sa part l’AGI hors de portée des modèles d’IA actuels. Quelle que soit leur réussite dans les tests.

«La plupart des grands modèles de langage actuels n’ont rien de vraiment intelligent. Ils reconnaissent des motifs, mais ne comprennent pas les causes», argumente-t-il. Sans compréhension des lois de cause à effet, l’IA reste limitée à l’intelligence élémentaire des corrélations.

Un système vraiment intelligent serait capable d’imaginer des scénarios alternatifs et de se demander: «Que se serait-il passé si…?». Les LLM semblent agir de la sorte, explique le spécialiste. En réalité, ils imitent efficacement les motifs rencontrés dans les textes rédigés par l’humain.

Pour Marco Zaffalon, la plupart des Big Tech préfèrent aujourd’hui améliorer leurs modèles au moyen du big data (des données en masse) et de raccourcis techniques plutôt que de viser une révolution scientifique, celle d’une IA qui se rapprocherait du cerveau humain. «Une intelligence véritable exigerait une approche entièrement nouvelle de l’IA, une approche qui viendrait compléter les modèles existants», juge le scientifique.

L’essor des modèles de raisonnement

Pour certains chercheurs, une nouvelle génération de modèles d’IA, appelés «modèles de raisonnement», pourrait contribuer au dépassement de certaines de ces limites.

Ces systèmes nouveaux recourent aussi à la prédiction statistique. Mais ils cherchent à simuler la pensée humaine en décomposant les problèmes complexes en éléments plus petits, puis en les résolvant de manière séquentielle.

Ces modèles peuvent résoudre des problèmes plus complexes, surtout quand ils sont associés à des LLM, explique Torsten Hoefler, informaticien à l’EPFZ. Son groupe de recherche planche activement sur l’amélioration de leurs performances, avec des résultats «presque comparables à ceux d’un humain», selon le chercheur.

Partout dans le monde, des entreprises comme Giotto.ai espèrent que les modèles de raisonnement les mèneront vers l’AGI. Giotto.ai assure que son système est beaucoup plus petit et plus efficace que les grands modèles de langage comme Grok 4 ou GPT-5. Mais vu de l’extérieur, ce qui lui permet d’atteindre ces résultats n’est pas clair. L’entreprise n’a pas dévoilé les détails techniques de son approche et prévoit de publier un rapport à la fin du concours.

La Suisse un zeste plus proche de l’IAG?

Une victoire de l’IA de Giotto.ai face aux géants américains serait une belle réussite pour la Suisse. Mais un modèle capable de résoudre des casse-têtes aurait encore à se trouver une utilité pratique. «Un être humain peut faire bien plus que résoudre des énigmes», lance Torsten Hoefler.

Interrogé par Swissinfo, le CEO de Giotto.ai Aldo Podestà affirme que si sa firme parvient à son objectif de se rapprocher d’une intelligence artificielle générale d’ici l’an prochain, toutes les applications seront possibles.

À l’IDSIA, Marco Zaffalon ne cache pas son scepticisme face à ce type de propos. Il doute que des systèmes principalement basés sur de grands modèles de langage et des prédictions statistiques puissent un jour atteindre un niveau d’intelligence humaine. Il relève aussi que les grandes promesses d’entreprises comme OpenAI et Anthropic se résument jusqu’ici à un battage médiatique visant à attirer des capitaux. Selon lui, aucune de ces firmes n’a été en mesure d’expliquer comment maîtriser des étapes cruciales comme le raisonnement causal.

«Avec ces modèles, l’intelligence humaine restera hors d’atteinte, à moins qu’ils ne soient complétés par des IA qui comprennent le monde et raisonnent à travers la causalité, ce qui n’est toujours pas le cas aujourd’hui», plaide-t-il.

Un des plus grands experts en IA de la planète, directeur du Beijing Institute for General Artificial Intelligence, le scientifique chinois Song-Chun Zhu insisteLien externe lui aussi sur la nécessité de développer des technologies d’IA radicalement différentes, capables de comprendre vraiment les lois de cause à effet plutôt que d’user de la prédiction.

IA de niveau humain: séduisante, mais risquée

Une IA de degré humain semble encore hors de portée. Et pour de nombreux chercheurs, ce n’est pas une mauvaise chose. Les modèles d’IA qui brouillent les frontières entre humains et machines sont problématiques sur le plan éthique, juge Peter G. Kirchschläger, professeur d’éthique à l’Université de Lucerne et professeur invité à l’EPFZ.

«Le risque n’est pas que les machines nous imitent, explique-t-il, mais qu’elles finissent par nous remplacer dans la prise de décisions sans que personne n’ait à rendre de comptes.»

L’IA recèle un potentiel énorme, juge l’éthicien. En particulier pour faire progresser la recherche scientifique ou résoudre les problèmes quotidiens de manière plus durable. Il insiste toutefois sur la nécessité de maintenir la distinction entre humains et machines, de sorte que chaque choix s’ancre dans la responsabilité de l’individu.

«Les décisions doivent demeurer entre les mains de l’être humain, plaide-t-il. Les machines doivent se limiter à les exécuter.»

Texte relu et vérifié par Gabe Bullard, traduit de l’anglais par Pierre-François Besson/op

Plus

En conformité avec les normes du JTI

Plus: SWI swissinfo.ch certifiée par la Journalism Trust Initiative

Vous pouvez trouver un aperçu des conversations en cours avec nos journalistes ici. Rejoignez-nous !

Si vous souhaitez entamer une conversation sur un sujet abordé dans cet article ou si vous voulez signaler des erreurs factuelles, envoyez-nous un courriel à french@swissinfo.ch.