Die Schweiz strebt nach «menschlicher» KI

Schweizer Entwickler:innen beteiligen sich am globalen Wettlauf um die Entwicklung einer künstlichen Intelligenz, die menschenähnlich denken und lernen kann. Während einige von einem baldigen Durchbruch sprechen, stellen andere die Frage, ob das überhaupt erstrebenswert ist.

Seit ChatGPT im Jahr 2022 einer breiten Öffentlichkeit zugänglich gemacht wurde, haben sich Millionen von Menschen daran gewöhnt, mit künstlicher Intelligenz zu interagieren, als wäre sie eine reale Person. Bisher hat sich jedoch noch kein KI-Tool als intelligent im «menschlichen» Sinn des Worts herausgestellt.

Die beliebtesten öffentlich zugänglichen KI-Modelle sind Large Language Models (LLMs). Sie treffen Vorhersagen auf der Grundlage wiederkehrender Muster, die sie aus riesigen Datenmengen erlernt haben.

Die meisten sind jedoch nicht in der Lage, in Echtzeit zu lernen und sich an neue Informationen anzupassen, wie der menschliche Verstand es tut.

«Sie geben uns die Illusion, dass sie genauso intelligent sind wie wir, aber das ist nur statistische Imitation, kein echtes Verständnis», sagt Torsten Höfler, Professor am Departement für Informatik der Eidgenössischen Technischen Hochschule Zürich (ETH).

Um die Kluft zwischen Mensch und Maschine zu überbrücken, arbeiten Unternehmen und Forschungseinrichtungen weltweit mit Hochdruck an der Entwicklung einer allgemeinen künstlichen Intelligenz (AGI) – einer Technologie, die menschliches Verständnis und Anpassungsfähigkeit nachbilden soll.

AGI ist das erklärte Ziel vieler Akteure im Bereich der KI, denn sie würde es Maschinen ermöglichen, praktisch jede Aufgabe mit der Genauigkeit und Flexibilität eines Menschen auszuführen.

In der Schweiz sind einige Entwickler:innen der Meinung, dass sie der menschlichen Intelligenz bereits sehr nahe gekommen sind.

Manche Expert:innen bezweifeln jedoch, dass LLMs oder ähnliche Modelle jemals ausreichen werden, um dieses Ziel zu erreichen. Zudem stellen sie die Frage in den Raum, ob die Entwicklung einer «menschlichen» KI überhaupt erstrebenswert ist.

Testen der maschinellen Intelligenz

Testen der maschinellen Intelligenz

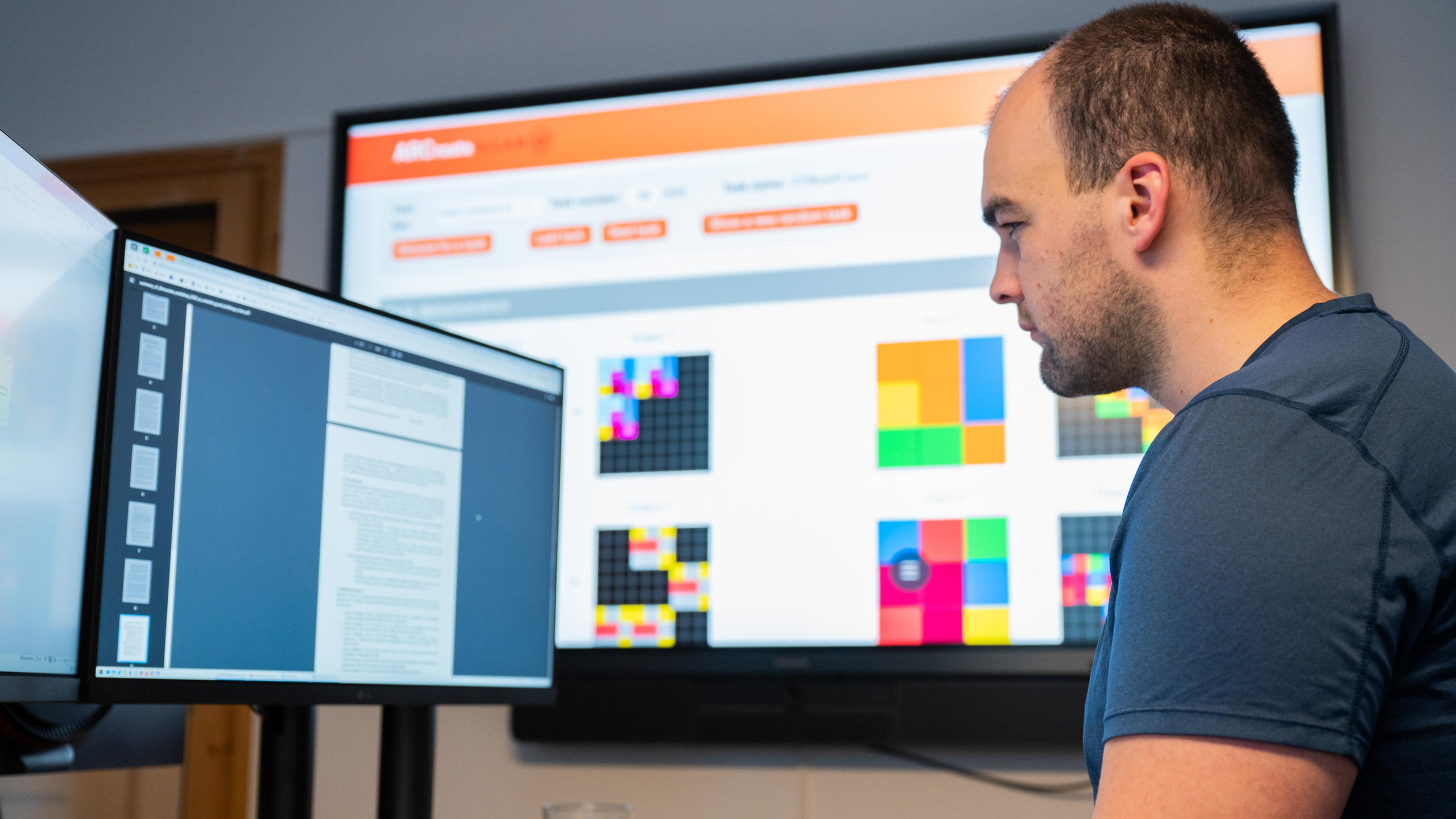

Im Mittelpunkt des Wettbewerbs steht das Schweizer Startup Giotto.ai, das derzeit die Rangliste des ARC-Preises anführtExterner Link.

Bei diesem globalen Wettbewerb wird anhand einer Reihe visueller Rätsel gemessen, wie nah KI-Systeme dem menschlichen Denken kommen.

Das Abstraction and Reasoning Corpus (ARC)Externer Link ist einer der weltweit führenden Massstäbe, um Fortschritte auf dem Weg zur künstlichen allgemeinen Intelligenz zu messen.

Es besteht aus visuellen Rätseln, die die Fähigkeit einer KI testen, abstrakt zu denken und aus Beispielen zu generalisieren – Aufgaben, die Menschen in der Regel relativ leicht lösen können, die aber für aktuelle KI-Systeme nach wie vor schwierig sind.

Zum Zeitpunkt der Erstellung dieses Artikels gibt Giotto.ai an, 27,08% der Rätsel gelöst zu haben. Damit werden etablierte grosse Sprachmodelle wie Grok 4 und GPT-5 übertroffen. Die aktuelle Etappe des Wettbewerbs endet am 3. November.

Das in Davos ansässige Forschungsinstitut Lab42 verfolgt ebenfalls das Ziel der allgemeinen künstlichen Intelligenz und unterstützt Programmierer weltweit, die versuchen, die ARC-Tests mit ihren eigenen Projekten zu lösen.

Im Jahr 2024 berichtete das InstitutExterner Link, dass eines seiner Teams einen neuen Weltrekord aufgestellt habe, indem es 34% der ARC-Tests in einem inoffiziellen Wettbewerb gelöst habe.

Mehr über das Lab42 in Davos in diesem Artikel:

Mehr

Mit «humanistischer» KI gegen China und die USA

Diese Leistung ist zwar beeindruckend, erreicht aber bei Weitem nicht das Niveau menschlicher Intelligenz. Laut François Chollet, dem Erfinder der ARC-Tests, sollte ein «intelligenter» Mensch in der Lage seinExterner Link, mehr als 95% der Quizfragen ohne Training zu lösen.

Mit einem Sieg in diesem Wettbewerb wollen Giotto.ai und Lab42 zeigen, dass sie kurz davorstehen, eine Technologie zu entwickeln, die funktioniert wie das menschliche Gehirn: kreativ sowie in der Lage, in Echtzeit zu lernen und schnell neue Fähigkeiten zu erwerben.

LLMs sind nicht intelligent genug

Marco Zaffalon, wissenschaftlicher Direktor des Dalle Molle Institute for Artificial Intelligence (IDSIA), ist der Meinung, dass AGI für aktuelle KI-Modelle unerreichbar bleiben wird – egal, wie gut sie in bestimmten Tests abschneiden.

«Die meisten der heutigen grossen Sprachmodelle haben nichts wirklich Intelligentes an sich – sie erkennen Muster, verstehen aber keine Ursachen», sagt er.

Solange KI die Gesetze von Ursache und Wirkung nicht verstehe, bleibt sie laut Zaffalon auf die grundlegende Intelligenz von Korrelationen beschränkt.

Ein wirklich intelligentes System wäre hingegen in der Lage, sich alternative Szenarien vorzustellen und die Frage zu stellen: «Was wäre passiert, wenn …?»

LLMs erwecken zwar den Anschein, dies zu tun, fügt Zaffalon hinzu, doch nur, weil sie gut darin seien, Muster aus von Menschen verfassten Texten zu imitieren.

Laut Zaffalon besteht das Problem bei der Entwicklung einer AGI darin, dass die meisten grossen Tech-Unternehmen es heute vorziehen, ihre Modelle mit Big Data und technischen Abkürzungen zu verbessern, statt eine echte wissenschaftliche Revolution anzustreben, um KI dem menschlichen Gehirn anzugleichen.

«Echte Intelligenz würde einen völlig neuen Ansatz für KI erfordern, der bestehende Modelle ergänzt», sagt der Wissenschaftler.

Der Aufstieg der Schlussfolgerungsmodelle

Einige Forscher:innen glauben, dass eine neue Generation von KI-Modellen, die als Schlussfolgerungssysteme bekannt sind, dazu beitragen könnte, einige dieser Einschränkungen zu überwinden.

Diese Systeme nutzen ebenfalls statistische Vorhersagen, versuchen jedoch, menschliches Denken zu simulieren, indem sie komplexe Probleme in kleinere Teilaufgaben zerlegen und diese nacheinander lösen.

Der Informatiker Torsten Hoefler von der ETH Zürich sagt, solche Systeme könnten komplexere Probleme bewältigen, besonders in Kombination mit grossen Sprachmodellen (LLMs).

Sein Forschungsteam arbeitet aktiv daran, ihre Leistungsfähigkeit zu verbessern, mit Ergebnissen, die der Wissenschaftler als «beinahe menschlich» beschreibt.

Giotto.ai ist nur eines von vielen Unternehmen weltweit, die darauf hoffen, dass Schlussfolgerungsmodelle sie auf dem Weg zur AGI voranbringen. Das Unternehmen gibt an, dass sein System deutlich kleiner und effizienter sei als LLMs wie Grok 4 oder GPT-5.

Wie genau es seine Ergebnisse erzielt, bleibt jedoch unklar. Giotto.ai hat die technischen Details seines Ansatzes bisher nicht offengelegt. Am Ende des Wettbewerbs will das Unternehmen einen Bericht veröffentlichen.

Mehr

Alles zum Thema «Wissenschaft»

Ist die Schweiz der allgemeinen künstlichen Intelligenz einen Schritt näher gekommen?

Sollte die KI von Giotto.ai den ARC-Preis vor den US-Giganten gewinnen, wäre das eine bemerkenswerte Leistung für die Schweiz. Es bleibt jedoch unklar, wie ein Modell, das Rätsel lösen kann, in der Praxis angewendet werden kann. «Ein Mensch kann viel mehr als nur Rätsel lösen», sagt Hoefler.

Im Gespräch mit Swissinfo.ch sagt Geschäftsführer Aldo Podestà, dass mit Giotto.ai jede Anwendung möglich sein werde, sollte es dem Unternehmen gelingen, innerhalb des nächsten Jahres der allgemeinen Intelligenz nahe zu kommen.

Zaffalon vom IDSIA bleibt gegenüber solchen Behauptungen skeptisch. Er bezweifelt, dass Systeme, die hauptsächlich auf grossen Sprachmodellen und statistischen Vorhersagen beruhen, jemals ein Intelligenzniveau erreichen können, das jenem des Menschen entspricht.

Zudem weist er darauf hin, dass ähnliche vollmundige Versprechen von Unternehmen wie OpenAI und Anthropic bislang vor allem dazu dienten, grosse Investitionssummen anzuziehen. Keines dieser Unternehmen habe bisher erklären können, wie grundlegende Herausforderungen wie etwa das kausale Denken bewältigt werden.

«Mit diesen Modellen wird menschliche Intelligenz in weiter Ferne bleiben, wenn sie nicht durch KI ergänzt werden, welche die Welt verstehen und durch Kausalität über sie nachdenken – was heute noch nicht der Fall ist», sagt er.

Der chinesische Wissenschaftler Song-Chun Zhu, einer der weltweit führenden KI-Experten und Direktor des Beijing Institute for General Artificial Intelligence, betont ebenfalls die Notwendigkeit, grundlegend neue KI-Technologien zu entwickelnExterner Link, die wirklich in der Lage sind, die Gesetze von Ursache und Wirkung zu verstehen, statt sich lediglich auf Vorhersagen zu stützen.

KI auf menschlichem Niveau: verführerisch, aber riskant

KI auf dem Niveau des Menschen scheint weiterhin ausser Reichweite zu sein. Für viele Forschende ist das jedoch gar nicht so schlecht.

KI-Modelle, welche die Grenzen zwischen Mensch und Maschine verwischen, seien ethisch problematisch, sagt Peter G. Kirchschläger, Professor für Ethik an der Universität Luzern und Gastprofessor an der ETH Zürich.

«Das Risiko besteht nicht darin, dass Maschinen uns imitieren, sondern darin, dass sie beginnen, Entscheide an unserer Stelle zu treffen, ohne dass jemand dafür Verantwortung übernimmt», sagt er.

Für Kirchschläger birgt KI grosses Potenzial, etwa um die wissenschaftliche Forschung voranzubringen oder Alltagsprobleme nachhaltiger zu lösen.

Er betont jedoch auch, wie wichtig es ist, die Grenze zwischen Mensch und Maschine aufrechtzuerhalten: «Entscheide müssen in den Händen von Menschen bleiben. Maschinen sollten sich darauf beschränken, sie auszuführen.»

Editiert von Gabe Bullard, Übertragung aus dem Englischen: Michael Heger/raf

Mehr

In Übereinstimmung mit den JTI-Standards

Einen Überblick über die laufenden Debatten mit unseren Journalisten finden Sie hier. Machen Sie mit!

Wenn Sie eine Debatte über ein in diesem Artikel angesprochenes Thema beginnen oder sachliche Fehler melden möchten, senden Sie uns bitte eine E-Mail an german@swissinfo.ch