La Svizzera aspira all’intelligenza artificiale “umana”

La Svizzera è entrata nella corsa mondiale per sviluppare un’intelligenza artificiale capace di “pensare” come gli esseri umani. Qualcuno ritiene di essere vicino al traguardo. È proprio così?

Dal lancio di ChatGPT nel 2022, milioni di persone si sono abituate a interagire con l’intelligenza artificiale (IA) come se fosse un individuo in carne e ossa. Ma finora nessuno strumento di IA ha dimostrato di essere intelligente nel senso “umano” del termine.

Le piattaforme di IA più diffuse tra il pubblico sono i modelli linguistici di grandi dimensioni (LLM), che fanno previsioni basate su schemi ricorrenti appresi da enormi quantità di dati. La maggior parte non è in grado di imparare in tempo reale e di adattarsi a nuove informazioni come fa la mente umana. “Ci danno l’illusione di essere intelligenti come noi, ma si tratta solo di imitazione statistica, non di vera comprensione”, afferma Torsten Hoefler, professore del dipartimento di informatica del Politecnico federale di Zurigo (ETHZ).

Per colmare il divario tra gli esseri umani e le macchine, le aziende e gli istituti di ricerca di tutto il mondo stanno facendo a gara per sviluppare l’intelligenza artificiale generale (AGI), ovvero un’IA capace comprendere e adattarsi a livello umano. L’AGI è l’obiettivo di molti nel campo dell’IA perché permetterebbe alle macchine di svolgere praticamente qualsiasi compito con la precisione e la flessibilità di una persona.

In Svizzera, c’è chi pensa di essere vicino al traguardo. Ma alcuni esperti ed esperte mettono in dubbio che gli LLM o modelli simili possano mai essere sufficienti per arrivarci e che l’IA “umana” sia davvero un obiettivo desiderabile.

Testare l’intelligenza artificiale

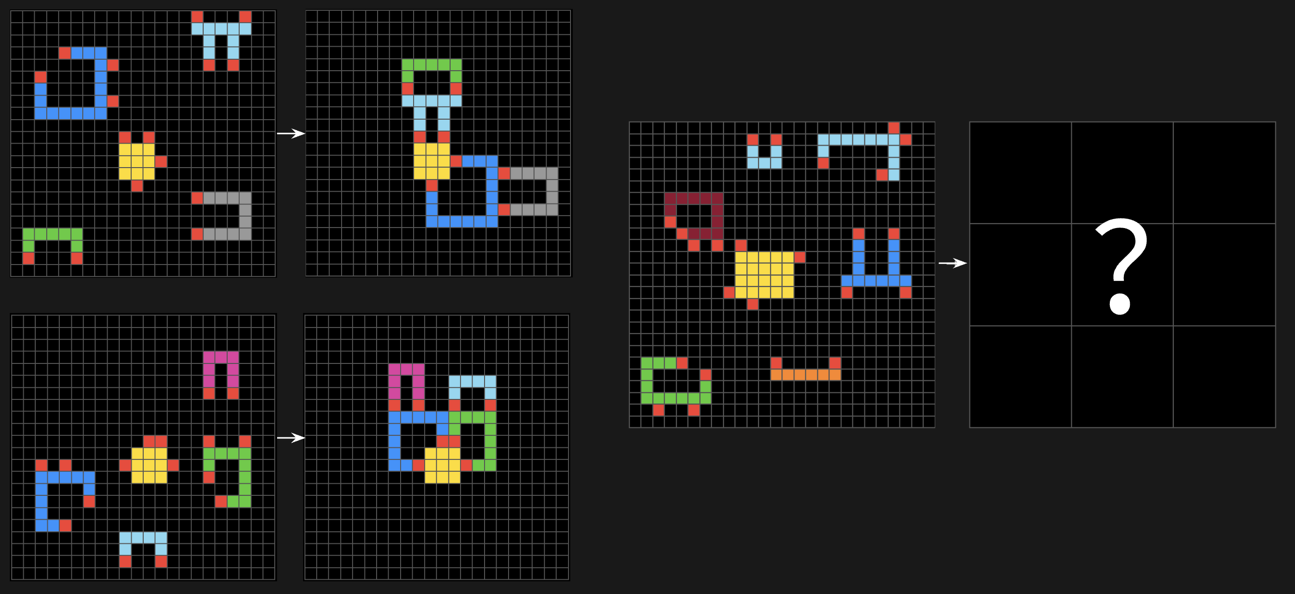

Al centro della corsa c’è una start-up svizzera, Giotto.ai, che attualmente è in testa alla classifica dell’ARC PrizeCollegamento esterno – una competizione globale che misura quanto i sistemi di intelligenza artificiale si avvicinino al ragionamento umano attraverso una serie di puzzle visivi.

L’Abstraction and Reasoning CorpusCollegamento esterno (ARC) è uno dei riferimenti principali a livello mondiale per misurare i progressi verso l’intelligenza artificiale generale. Consiste in puzzle visivi che mettono alla prova la capacità di un’IA di ragionare in modo astratto e generalizzare a partire da esempi. Si tratta di compiti che gli esseri umani sono in grado di risolvere con relativa facilità, ma che sono ancora difficili per gli attuali sistemi di IA.

Al momento in cui scriviamo, Giotto.ai afferma di aver risolto il 27,08% dei puzzle, superando LLM molto popolari come Grok 4 e GPT-5. La competizione di quest’anno si concluderà il 3 novembre.

Anche l’istituto di ricerca Lab42, con sede a Davos, ambisce all’intelligenza artificiale generale, supportando chi programma algoritmi in tutto il mondo in grado di risolvere questi test. Nel 2024, l’istituto ha dichiaratoCollegamento esterno di aver stabilito un nuovo record mondiale con uno dei suoi team, che ha risolto il 34% dei test ARC in una sfida non ufficiale.

>> Per saperne di più su Lab42 a Davos:

Altri sviluppi

Un nuovo centro per l’intelligenza artificiale “neutrale” sta nascendo tra le Alpi svizzere

Sebbene la performance sia impressionante, è ancora molto al di sotto dell’intelligenza umana. Il creatore del test ARC, François Chollet, sostieneCollegamento esterno che un essere umano “intelligente” dovrebbe essere in grado di risolvere più del 95% dei quiz senza addestramento.

Sia i team di ricerca di Giotto.ai che di Lab42 credono che vincere il concorso possa avvicinarli alla creazione di una tecnologia che funziona come il cervello umano: creativa, capace di apprendere in tempo reale e rapida nell’acquisire nuove competenze.

Gli LLM non sono abbastanza intelligenti

Marco Zaffalon, direttore scientifico dell’Istituto Dalle Molle di studi sull’intelligenza artificiale (IDSIA) di Lugano, ritiene che l’intelligenza generale sia al di là della portata degli attuali modelli di IA, a prescindere da quanto bene possano fare in determinati test.

“La maggior parte dei modelli linguistici di grandi dimensioni di oggi non ha nulla di veramente intelligente: riconosce gli schemi, ma non comprende le cause”, spiega. Senza la comprensione delle leggi di causa ed effetto, secondo Zaffalon, l’IA rimane confinata al livello base dell’intelligenza: quello delle correlazioni.

Un sistema davvero intelligente sarebbe in grado di immaginare scenari alternativi e di chiedersi “cosa sarebbe successo se…”. Gli LLM possono sembrare in grado di farlo, ma solo perché sono bravi a imitare gli schemi che trovano nei testi scritti dagli esseri umani, aggiunge Zaffalon.

Secondo lo scienziato, il problema è che oggi le aziende preferiscono migliorare i loro modelli con i big data e scorciatoie ingegneristiche, invece di aspirare a una vera e propria rivoluzione scientifica per rendere l’intelligenza artificiale più simile al cervello umano. “La vera intelligenza richiederebbe un approccio totalmente nuovo all’IA, che integri i sistemi esistenti”, afferma Zaffalon.

L’ascesa dei modelli di ragionamento

Alcune ricercatrici e ricercatori ritengono che una nuova generazione di modelli di IA – noti come sistemi di ragionamento – potrebbe permettere di superare alcune di queste limitazioni.

Anche questi sistemi si avvalgono della previsione statistica, ma cercano di simulare il pensiero umano suddividendo problemi complessi in parti più piccole e risolvendoli in sequenza.

L’informatico Torsten Hoefler dell’ETHZ sostiene che tali sistemi possono affrontare problemi più complessi, soprattutto se abbinati agli LLM. Il suo gruppo sta lavorando attivamente per migliorarne le prestazioni, con risultati che lo scienziato descrive come “quasi umani”.

Le aziende di tutto il mondo, tra cui Giotto.ai, sperano che i modelli di ragionamento le portino all’AGI. Giotto.ai afferma che il suo sistema è molto più piccolo ed efficiente rispetto a LLM come Grok 4 o GPT-5, ma non è ancora chiaro come riesca a ottenere questi risultati. La start-up non ha reso pubblici i dettagli tecnici del suo approccio e prevede di pubblicare un report al termine della competizione.

IA: intelligenza artificiale

L’insieme di tecniche che permettono alle macchine di imitare alcune capacità umane, come l’apprendimento, il linguaggio o la percezione visiva.

LLM: modello linguistico di grandi dimensioni (Large Language Model)

Si tratta di un modello di intelligenza artificiale addestrato su enormi quantità di testo. Utilizza la statistica per prevedere la parola successiva in una frase, producendo risposte coerenti ma basate su correlazioni più che su comprensione.

AGI: intelligenza artificiale generale (Artificial General Intelligence)

Forma di intelligenza artificiale in grado di comprendere, apprendere e adattarsi come un essere umano, svolgendo qualsiasi compito cognitivo senza addestramento specifico.

La Svizzera vicina all’intelligenza artificiale generale?

Se l’intelligenza artificiale di Giotto.ai dovesse vincere l’ARC Prize, superando i giganti statunitensi, sarebbe un risultato notevole per la Svizzera. Ma resta da capire in che modo un modello in grado di risolvere puzzle possa essere applicato nella pratica. “Un essere umano può fare molto di più che risolvere puzzle”, afferma Hoefler.

Intervistato da SWI Swissinfo.ch, il CEO Aldo Podestà afferma che se Giotto.ai raggiungerà l’obiettivo di avvicinarsi all’intelligenza generale entro il prossimo anno, ogni applicazione sarà possibile.

Zaffalon resta molto scettico di fronte a dichiarazioni del genere. Dubita che sistemi basati principalmente su modelli linguistici di grandi dimensioni e previsioni statistiche possano davvero raggiungere un livello di intelligenza paragonabile a quello umano. E fa notare che promesse simili fatte da aziende come OpenAI e Anthropic si sono finora rivelate poco più che trovate pubblicitarie per attirare grandi capitali. Nessuna di queste aziende, dice Zaffalon, è infatti riuscita a spiegare come superare sfide fondamentali come il ragionamento causale.

“Con questi modelli, l’intelligenza umana rimarrà un obiettivo lontano, a meno che non siano integrati da IA in grado di comprendere il mondo e ragionare su di esso attraverso la causalità, cosa che oggi non è ancora avvenuta”, ribadisce.

Anche lo scienziato cinese Song-Chun Zhu, uno dei maggiori esperti mondiali di IA e direttore dell’Istituto di Pechino per l’intelligenza artificiale generale, sottolinea via e-mail la necessità di sviluppare tecnologie di IA radicalmente diverse, in grado di comprendere realmente le leggi di causa ed effetto e di non utilizzare la previsione.

IA di livello umano: seducente ma rischiosa

L’IA di livello umano sembra ancora fuori portata. E per molti ricercatori e ricercatrici, questo non è un male. I modelli di IA che sfumano i confini tra esseri umani e macchine sono problematici a livello etico, afferma Peter G. Kirchschläger, professore di etica all’Università di Lucerna e visiting professor all’ETHZ.

“Il rischio non è che le macchine ci imitino”, spiega, “ma che finiscano per sostituirci nel prendere decisioni senza che nessuno ne risponda”.

Per Kirchschläger, l’IA ha un grande potenziale, ad esempio per far progredire la ricerca scientifica o risolvere i problemi quotidiani in modo più sostenibile. Tuttavia, insiste sul fatto che è fondamentale mantenere viva la distinzione tra esseri umani e macchine, in modo che ogni scelta rimanga ancorata alla responsabilità dell’individuo.

“Le decisioni devono rimanere nelle mani di un essere umano: le macchine dovrebbero limitarsi a eseguirle”, conclude.

A cura di Gabe Bullard

Altri sviluppi

In conformità con gli standard di JTI

Altri sviluppi: SWI swissinfo.ch certificato dalla Journalism Trust Initiative

Potete trovare una panoramica delle discussioni in corso con i nostri giornalisti qui.

Se volete iniziare una discussione su un argomento sollevato in questo articolo o volete segnalare errori fattuali, inviateci un'e-mail all'indirizzo italian@swissinfo.ch.