Wie Schweizer Wissenschaftler versuchen, Deepfakes zu erkennen

Mit Hilfe der KI, also der künstlichen Intelligenz, werden gefälschte Fotos und Videos immer raffinierter. Wie beurteilen Schweizer Experten die Risiken dieser so genannten Deepfakes? Und wie weit sind sie mit der Entwicklung von Detektoren?

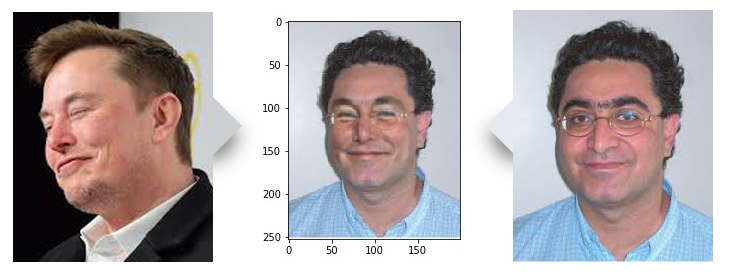

In einem Computerlabor auf dem riesigen Campus der Eidgenössischen Technischen Hochschule Lausanne (EPFL) betrachtet ein kleines Team von Ingenieuren das Bild eines lächelnden, bebrillten Mannes mit heller Hautfarbe und dunklen Locken.

«Ja, das ist gut», sagt der leitende Forscher Touradj Ebrahimi, der mit dem Mann auf dem Bildschirm eine gewisse Ähnlichkeit hat. Das Team hat Bilder von Ebrahimis Gesicht mit Online-Bildern des Tesla-Gründers Elon Musk manipuliert, um Deepfakes, also Fotos und Videos herzustellen, die mit Hilfe von künstlicher Intelligenz gefälscht werden.

Es ist eine von vielen gefälschten Illustrationen – einige realistischer als andere –, die Ebrahimis Team bei der Entwicklung von Software zusammen mit der Cyber-Sicherheitsfirma Quantum IntegrityExterner Link (QI) entwickelt hat. Deren Ziel: manipulierte Bilder, einschliesslich Deepfakes, zu erkennen.

Mit Hilfe des maschinellen Lernens, dem gleichen Prozess, der hinter der Erstellung von Deepfakes steht, erkennt die Software den Unterschied zwischen echten und gefälschten Bildern: Ein «Generator» füttert sie mit gefälschten Bildern, die ein «Detektor» dann zu erkennen versucht.

«Mit viel Übung können Maschinen helfen, Fälschungen auf die gleiche Weise zu erkennen wie dies ein Mensch kann», erklärt Ebrahimi. «Je mehr sie benutzt wird, desto besser wird sie.»

Gefälschte Fotos und Videos gibt es seit dem Aufkommen von Multimedia. Aber KI-Techniken haben es Fälschern erst kürzlich ermöglicht, Gesichter in einem Video zu verändern oder den Anschein zu erwecken, dass eine Person etwas sagt, was sie nie getan hat. In den letzten Jahren hat sich die Deepfake-Technologie schneller verbreitet, als die meisten Experten erwartet hatten.

Die Herstellung von Deepfake-Videos ist laut dem International Risk Governance CenterExterner Link (IRGC) der EPFL «exponentiell schneller, einfacher und billiger» geworden, dank der Verbreitung von benutzerfreundlichen Software-Instrumenten und bezahlten Online-Diensten. «Gerade weil die Entwicklung so schnell voranschreitet, müssen wir aufzeigen, wohin dies gehen könnte – welche Sektoren, Gruppen und Länder betroffen sein könnten», sagt der stellvertretende IRGC-Direktor Aengus Collins.

Ein grosser Teil der bösartigen Deepfakes wird in der Pornografie verwendet. Aber die gleichen Techniken werden auch zur Manipulation der öffentlichen Meinung eingesetzt.

Ein schnelllebiges Gebiet

Als Ebrahimi vor drei Jahren begann, mit QI an Erkennungssoftware zu arbeiten, waren Deepfakes nicht auf dem Radar der meisten Forscher. Damals waren die Kunden von QI besorgt über gefälschte Bilder von Unfällen, die bei betrügerischen Forderungen gegenüber Auto- und Hausratsversicherungen verwendet wurden. Bis 2019 erreichten Deepfakes jedoch einen Grad an Raffinesse, dass das Projekt-Team beschloss, diesem Thema viel mehr Zeit zu widmen.

«Ich hätte nicht gedacht, dass sich die Technologie so schnell entwickeln würde», sagt Anthony Sahakian, der Chef von QI.

Sahakian hat aus erster Hand mitverfolgt, wie weit Deepfake-Techniken gekommen sind, um realistische Ergebnisse zu erzielen. Als eines der jüngsten Beispiele nennt er die Manipulation von Gesichtern auf Passfotos, bei dem es gelingt, alle Siegel auf dem Pass intakt zu lassen.

Es sind nicht nur Verbesserungen der Manipulationstechniken, die Experten wie ihn betreffen. Die Zahl der online verfügbaren Deepfake-Videos hat sich innerhalb von neun Monaten fast verdoppelt und ist bis im September 2019 nach einer Schätzung von DeeptraceExterner Link, einer niederländischen Cyber-Sicherheitsfirma, auf 14’678 angestiegen.

Risikobereiche

Die meisten Opfer von Deepfakes, die mit der Absicht geschaffen wurden, Schaden anzurichten, sind Frauen, deren Gesichter auf pornografisches Material oder Bilder übertragen wurden. Diese Art der Nutzung machte im Jahr 2019 laut Deeptrace 96% der Online-Deepfake-Videos aus. Bei einigen handelt es sich um sogenannte «Rachepornografie», mit denen der Ruf der Opfer beschmutzt wird.

«Online-Belästigung und Mobbing sind wiederkehrende Themen», sagt Collins.

Von jenen Deepfakes, die für kommerziellen Betrug eingesetzt werden, sind weniger Fälle bekannt. Die meisten davon operieren mit Stimm-Imitationen, um die Opfer dazu zu bringen, dem Täter Geld zu schicken.

Trotzdem bleiben insbesondere Versicherungsunternehmen nicht untätig. An einem von IRGC kürzlich durchgeführten Workshop nahmen Vertreter von Zurich Versicherung, Swiss Re und BNP Paribas teil. Sahakian von QI sagt, dass die potenzielle Verwendung von gefälschten Videos mit Unfallschäden die Firmen beunruhigten, mit denen er zusammenarbeite.

«Die Technik ist nun vorhanden, um das heutige KYC [Know Your Customer/Erkenne deine Kunden] überflüssig zu machen», sagt er mit Bezug auf den Prozess für die Identitätsüberprüfung der Kunden und deren Absichten.

Die Verbreitung von Deepfakes hat auch Fragen zum Einflusspotential auf den politischen Prozess aufgeworfen. Befürchtungen wurden bestätigt, als ein manipuliertes Video auftauchte, das Nancy Pelosi, die Sprecherin des US-Repräsentantenhaus, so darstellt, als ob sie lallend eine Rede halte.

Es handelte sich um eine Low-Tech-Manipulation, ein sogenanntes «shallowfake», oder wie Ebrahimi sich ausdrückt: «Es ist ein Zeichen dafür, was getan werden kann und welche Absicht diese Art von manipulierten Medien antreibt.

Laut dem Risikoexperten Collins muss der Einsatz synthetischer Medien in der Politik in einen Kontext gestellt werden.

«Es ist möglich, dass Deepfakes für Wahlmanipulationen eingesetzt werden, aber ich würde das Risiko nicht überbewerten, sonst riskiert man, den Blick auf das grosse Ganze zu verlieren», warnt er.

Deepfakes signalisierten aber «die potenzielle Kluft, die sich auftut zwischen der Geschwindigkeit, mit der sich das digitale Informationssystem entwickelt, und der Fähigkeit der Gesellschaft, sich daran anzupassen».

Deepfakes können auch für Desinformationskampagnen benutzt werden und das Gefüge zwischen Wahrheit und Vertrauen untergraben.

KI schaffen und entdecken

Die Technologie mag bei manchen Leuten Panik auslösen. Andere bezweifeln, ob Deepfake-Videos realistisch genug seien, um die meisten Benutzer zu täuschen. Experten sagen, dass die Qualität von Deepfakes auch heute noch weitgehend von den Fähigkeiten der Täter abhänge.

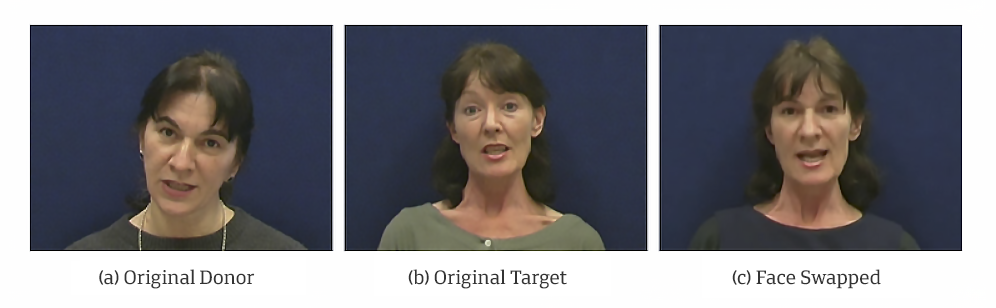

Das Vertauschen von Gesichtern auf einem Video führe unweigerlich zu einigen Unvollkommenheiten im Bild, sagt Sébastien Marcel, Experte für biometrische Sicherheit.

«Die Qualität wird sehr unterschiedlich sein, je nachdem, welche manuellen Eingriffe zur Vergrösserung des Bildes vorgenommen werden», sagt er. Wenn der Urheber sich die Mühe macht, das Ergebnis zu verfeinern, kann die Fälschung sehr schwer zu erkennen sein, sagt er.

Marcel und seine Kollegen vom Forschungsinstitut Idiap in Martigny in der Südwestschweiz arbeiten an einer eigenen Erkennungssoftware. Diese entstand aus dem Bedürfnis, Gesichts- und Stimmmanipulationen auf Videos zu identifizieren. Es ist ein langfristig ausgerichtetes Projekt.

«Dieses Problem kann nicht von heute auf morgen gelöst werden», sagt Marcel. «Es ist ein wachsendes Forschungsthema. Deshalb planen wir, mehr Ressourcen in diesen Bereich zu investieren.»

«Es ist unwahrscheinlich, da Ei des Kolumbus zu finden», sagt Collins. «Egal, welche Art von Erkennungstechniken es gibt, ein Täter wird immer einen Weg finden, diese zu umgehen.»

Ebrahimi und Marcel sagen beide, dass ihr Ziel nicht darin bestehe, ein absolut zuverlässiges Instrument zu entwickeln. Ein Teil der Aufgabe des Detektors sei es vorauszusehen, in welche Richtung die Manipulatoren gehen könnten. Und dem entsprechend müsse er seine Methoden anpassen.

Marcel von Idiap prophezeit, dass Täter in der Lage sein werden, nicht nur einen Aspekt, also zum Beispiel ein Gesicht, sondern das gesamte Video zu verändern.

«Die Qualität der Deepfakes wird sich verbessern, also müssen wir auch die Detektoren verbessern», und zwar bis zu dem Punkt, bei dem das Kosten-Nutzen-Verhältnis der Herstellung von bösartigen Deepfakes für die Täter nicht mehr stimmt.

Social-Media-Plattformen vs. Deepfakes

Twitter führte im März 2020 eine neue Regel gegen das «Teilen» synthetischer oder manipulierter Medieninhalte ein, die Schaden anrichten können. Zu den Massnahmen gehören die Kennzeichnung solcher Tweets und die Anzeige von Warnhinweisen für die Nutzer.

YouTube, das zu Google gehört, versprach, dass es keine gefälschten Videos im Zusammenhang mit den Wahlen und der Volkszählung in den USA im Jahr 2020 tolerieren werde, welche die Öffentlichkeit in die Irre führen sollen.

Facebook hat eine Prämie im Wert von mehr als 10 Millionen Dollar ausgesetzt, um Forscher auf dem Gebiet der Erkennung weltweit zu unterstützen. Sowohl Facebook als auch Google haben Datensätze von Deepfake-Bildern veröffentlicht, um Forscher bei der Entwicklung von Erkennungstechniken zu unterstützen.

(Übertragung aus dem Englischen: Peter Siegenthaler)

In Übereinstimmung mit den JTI-Standards

![Félix Vallotton - Gabrielle Vallotton Seated in a Rocking Chair [1902]](https://www.swissinfo.ch/content/wp-content/uploads/sites/13/2025/06/53715547480_948a0f3612_o.jpg?ver=af84b45e)

Einen Überblick über die laufenden Debatten mit unseren Journalisten finden Sie hier. Machen Sie mit!

Wenn Sie eine Debatte über ein in diesem Artikel angesprochenes Thema beginnen oder sachliche Fehler melden möchten, senden Sie uns bitte eine E-Mail an german@swissinfo.ch