Die KI würde den Mainstream wählen, zeigt ein Experiment der ETH Zürich

Ein Experiment an der ETH Zürich zeigt, dass Chat-GPT anders abstimmt als Menschen. ETH-Computerwissenschaftler Joshua Yang erklärt Swissinfo, wie KI trotzdem die Demokratie verändern wird.

Wenn man Chat-GPT wählen liesse, würde sich das Sprachmodell wahrscheinlich für altbekannte Parteien entscheiden. Das kann man aus einer wissenschaftlichen Untersuchung der ETH Zürich herauslesen. Demnach entscheidet Chat-GPT stromlinienförmiger als es Menschen tun.

Wie konnte das Computational Social Science-Team der ETH Zürich das überhaupt herausfinden?

Die grossen Sprachmodelle sind darauf programmiert, auf politische Fragen ausweichend zu reagieren. «Wenn man Chat-GPT gefragt hatte, ob man seine Stimme Donald Trump oder Kamala Harris geben soll, sagte die KI, sie sei neutral, und gab keine Antwort», sagt ETH-Computerwissenschaftler Joshua Yang gegenüber SWI swissinfo.ch.

Chat-GPT, LLaMa und 180 Menschen

Also fragte das Computational Social Science-Team nicht nach Entscheiden zur grossen Politik, sondern bat die KI-Modelle Chat-GPT4 und LLaMA-2 um deren Meinung zu lokalen, vordergründig unpolitischen Stadtentwicklungsprojekten.

Darunter waren etwa eine autofreie Langstrasse, ein multikulturelles Festival auf dem Sechseläutenplatz oder ein Kinderfest im Leutschenpark. Welche der 24 Projekte würde die KI auswählen, um die Stadt Zürich für ihre Bürger:innen besser zu machen?

Die Ergebnisse der KI-Modelle verglichen die Wissenschaftler:innen dann mit jenen von 180 menschlichen Teilnehmer:innen in einem analogen Experiment mit denselben Projekten.

Menschliche und KI-Teilnehmer:innen trafen ihre Entscheidungen in Durchläufen mit verschiedenen Setups und Wahlverfahren. Mal verteilten sie Punkte für Projekte, mal wählten sie so viele Projekte aus, wie sie wollten. Auch mit dem Ranked-Choice-VerfahrenExterner Link machte man Tests.

Die Ergebnisse dieses Experiments lassen sich vor allem auf partizipative Budget-Entscheide und Wahlen mit mehreren Gewinner:innen anwenden – etwa Verhältniswahlen, wo Parteien anteilmässig zu ihrem Ergebnis Vertretende von ihren Wahllisten in ein Parlament entsenden.

Begrenzt ist die Aussagekraft der ETH-Studie hingegen für Wahlen mit nur einem einzelnen Gewinner:in – wie etwa US-Präsidentschaftswahlen.

KI-Modelle zeigten «einheitlicheres Verhalten»

Generell waren die Unterschiede zwischen Menschen und KI gross. Selbst dann, wenn die KI dazu aufgefordert war, die Rolle eines Menschen einzunehmen.

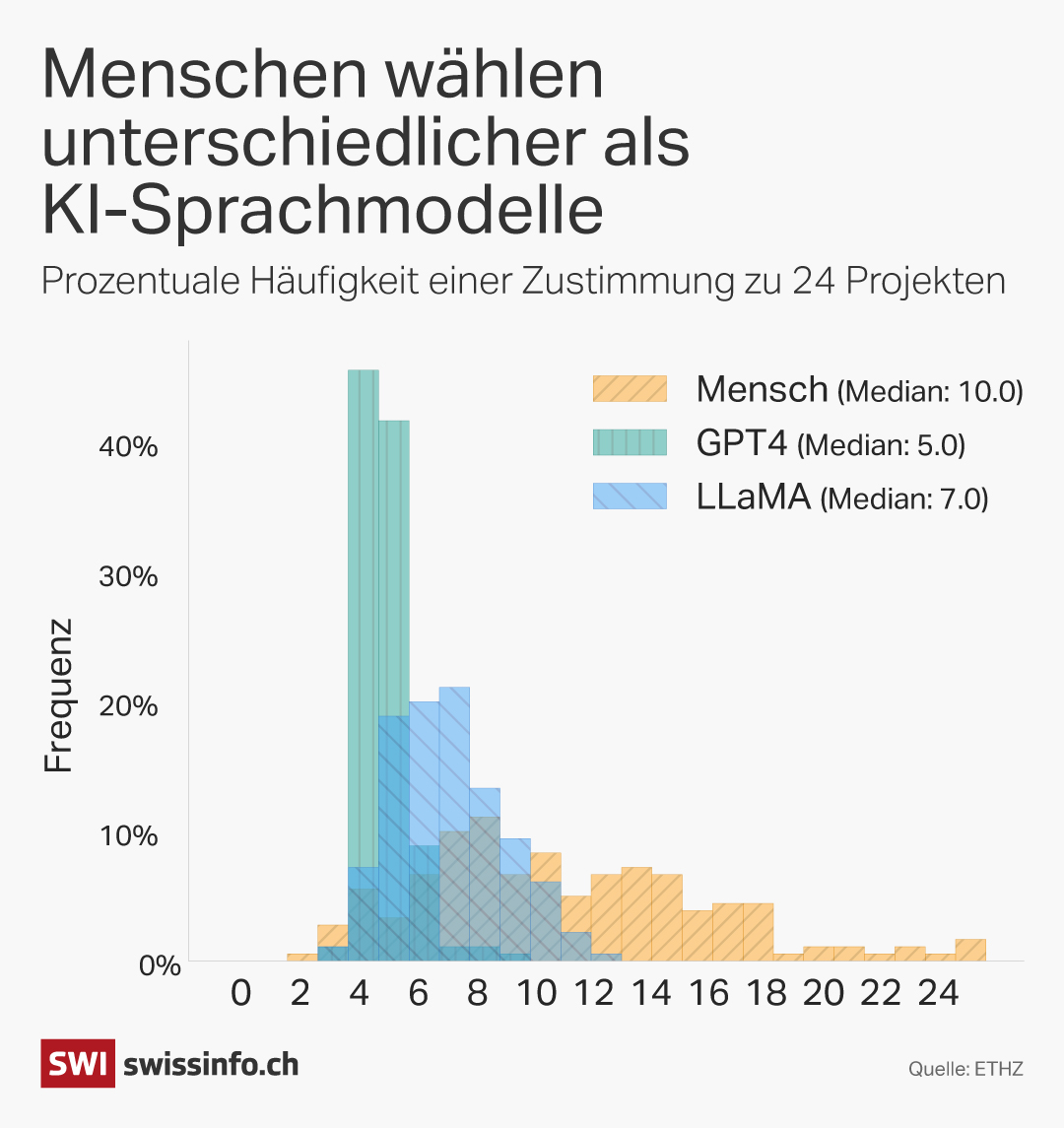

Die KI-Modelle entschieden sich häufig für dieselbe Anzahl Projekte und zeigten ein «einheitlicheres Verhalten» als Menschen, wie es in der Studie heisstExterner Link.

Chat-GPT wählte fast immer vier oder fünf Projekte aus, während sich die 180 Menschen für eine ganz unterschiedliche Anzahl Projekte erwärmen konnten.

Dieses Ergebnis bestätigt laut der Studie, dass «synthetische KI-simulierte Stichproben einen WEIRD-Bias (westlich, gebildet, industrialisiert, reich, demokratisch)» haben und «oft keine bedeutsame Varianz (oder Diversität) in ihren Urteilen» zeigen.

Gleichzeitig liess sich die KI in ihrer Entscheidung sogar von der Reihenfolge der Projekte auf der Liste beeinflussen. Das zeigt die Grenzen der Entscheidungskompetenz: Man stelle sich vor, Menschen würden eine andere Partei wählen, wenn diese zuunterst statt zuoberst auf dem Wahlzettel steht.

KI nur mit «menschzentriertem Ansatz» in Demokratie

Immerhin entschieden sich die KI-Modelle häufiger für günstige Projekte. Die Studie anerkennt dies und weist daraufhin, dass menschlichen Wähler:innen häufig Kostenbewusstsein fehle.

Die Forschung des ETH-Teams nimmt Bezug auf die Ideen von César Hidalgo zu digitalen KI-Zwillingen, die Politiker:innen ersetzen sollen und zum Vorschlag zweier Ökonomen, jeder stimmberechtigten Person einen digitalen Zwilling zuzuordnen.

Lesen Sie hier unseren Artikel über die Idee mit digitalen Zwillingen die Demokratie zu verändern:

Mehr

«Digitale Bürger» als Idee für die Demokratie in der Schweiz – und überall

Die StudieExterner Link, die Yang an der Conference on AI, Ethics, and Society im kalifornischen San José präsentierte, mahnt zur Vorsicht. Ein «menschzentrierter Ansatz» sei «essenziell», damit KI die «kollektive Intelligenz, die aus den vielfältigen menschlichen Vorlieben in der Gesellschaft hervorgeht» unterstütze und nicht kompromittiere.

Stattdessen solle man KI-Modelle «in einem Human in the loop-Rahmen» einsetzen. So könne ein KI-Agent die menschliche Entscheidungsfindung verbessern. Etwa, indem die KI Hintergrundwissen zu einem Thema aufbereitet, zusammenfasst oder erklärt.

Wie reguliert man den Umgang mit sensiblen Personendaten?

«Unser Interesse war, herauszufinden, wie sich Sprachmodelle auf die Demokratie, wie wir sie kennen, auswirken», sagt Joshua Yang. «Bereits jetzt stellen viele Leute Chat-GPT ihre Fragen. Das Sprachmodell informiert sie und wirkt so an ihren politischen Entscheidungen mit.»

Die heikle Frage bleibt der Umgang mit persönlichen Daten. «Mit welchen Angaben füttern wir eine KI, wenn wir sie bitten, die Perspektive einer Person einzunehmen?» Es gibt die Möglichkeit, sensible, demografische Daten wie Hautfarbe und Religion als Grundlage zu nehmen, oder gar das Transkript eines langen, persönlichen Gesprächs mit der Person.

Man kann die Personas auch auf Grundlage einer Meinungsbefragung erstellen, ähnlich wie bei Smartvote. In ihrem Experiment setzte das ETH-Team auf diesen Ansatz. Laut Yang sei dies womöglich nicht weniger effizient. Er hofft auf klare ethische und gesetzliche Richtlinien und eine gesellschaftliche Diskussion darüber, wo man die Linie zwischen Funktionalität und Privatsphäre zieht.

Schweizer Demokratie sei «ideales Testgelände» für KI-Agenten

Während die Studie eher kritische Aspekte betont, ist im Gespräch mit Yang durchaus Begeisterung für KI-Modelle spürbar: «Ich bin vorsichtig optimistisch, dass KI viel Potenzial für die Demokratie birgt.» Die KI könne Menschen helfen, häufigere und bessere Entscheide zu treffen – ohne ihnen Agency zu nehmen.

Die Schweiz mit ihren häufigen Volksabstimmungen sei «ein ideales Testgelände» für KI-Technologien. Denn die KI-Modelle seien besser darin, bei Volksabstimmungen zu helfen, denen man sich rational nähern kann, als bei von Emotionen getriebenen Wahlen. Dabei könnten sie gerade in lokalen Fragen womöglich die tiefe Stimmbeteiligung steigern.

Denkbar sei etwa ein digitales Abstimmungsbüchlein, das die Schweizer:innen nicht nur lesen, sondern befragen können. Das könnte jene motivieren, die aus mangelndem Wissen der Abstimmung fernbleiben.

«Wenn dafür ein spezifischer KI-Agent mit der Fülle für die Aufgabe relevanten Daten geschaffen wird, besteht auch ein signifikant kleineres Risiko, dass dieser falsche Fakten vermittelt. KI-Agenten halluzinieren dann, wenn sie keinen Zugang zur korrekten Antwort haben», führt Yang aus.

Grosse Sprachmodelle wie Chat-GPT sind dafür aber ungeeignet, weil diese gleichermassen auf relevante und irreführende Daten zurückgreifen.

Global sieht Yang, der in lokalen Demokratieprojekten in der Schweiz und in Taiwan mitwirkt, die Chance, dass KI direktdemokratischen (und deliberativen) Instrumenten Aufschwung bringt. Zuerst werden, so glaubt Yang, einzelne Politiker:innen und Gruppen auf KI-Agenten setzen, die Diskussionen auswerten und ihnen Argumente, Kompromisse und Handlungsoptionen aufbereiten.

Nach und nach könnten KI-Agenten dann Teil der Institutionen werden.

Editiert von Mark Livingston

In Übereinstimmung mit den JTI-Standards

Einen Überblick über die laufenden Debatten mit unseren Journalisten finden Sie hier. Machen Sie mit!

Wenn Sie eine Debatte über ein in diesem Artikel angesprochenes Thema beginnen oder sachliche Fehler melden möchten, senden Sie uns bitte eine E-Mail an german@swissinfo.ch